Table of Contents

Der alte und der neue Mechanismus Teil 2 – Erklärungsversuche zum Verständnis des reduktionistischen und positivistischen Weltbildes

Der hier veröffentlichte 2. Teil des Artikels zum „alten und neuen Mechanismus“ wurde mir freundlicherweise ebenfalls von Herrn Dr. Gregorio Demarchi vom Institut für Philosophie von der Friedrich-Schiller-Universität Jena zur Veröffentlichung auf meiner Seite zur Verfügung gestellt.

Der Kontakt zu dem Autor und die Möglichkeit zur Veröffentlichung beider Teile des Artikels „Der alte und der neue Mechanismus“ wurde mir durch die sehr freundliche und hilfsbereite Unterstützung von Andrin Kohler (head of the German section) von der in punkto Philosophie international sehr bekannten schweizerischen Seite philosophie.ch ermöglicht. Ein zukünftiges „Joint-Venture“ beider Seiten ist auch bereits in Planung, worauf ich an dieser Stelle schon einmal hinweisen darf. Um den hier vorliegenden Text besser einordnen zu können, seien mir hier vielleicht noch ein paar einleitende Worte zur Erläuterung gestattet.

In diesem 2. Teil des Artikels wird meines Erachtens der Komplexität biologischer Systeme Rechnung getragen und insofern dem mereologischen Fehlschluss im alten mechanistischen Weltbild, dass das Ganze immer mehr als die Summe seiner Teile, als Konstruktionsfehler im Reduktionismus verwiesen. In diesem Zusammenhang wird auch auf das Phänomen der „Emergenz“ im neuen mechanistischen Weltbild des Neo-Positivismus eingegangen. Aus diesem Grunde eignet sich dieser Artikel wiederum ausgezeichnet, um die methodischen Konzeptionen des Reduktionismus und Positivismus aufzuklären und besser verständlich zu machen. Die Kritik zu beiden Positionen hatte ich ja bereits des Häufigeren in meiner Trilogie zur Wissenschaftstheorie erläutert. Die in diesem Artikel geäußerten Analyseergebnisse sind ebenfalls sehr aufschlussreich in Bezug auf die Möglichkeit der Konstitution von einer starken Künstlichen Intelligenz. Aber nun möchte ich lieber noch einmal Herrn Demarchi zu diesem Thema zu Worte kommen lassen.

Gastbeitrag von Dr. Gregorio Demarchi: „Der alte und der neue Mechanismus – Teil 2“

Dieser Beitrag bildet die Fortsetzung von diesem hier über Descartes und die Entstehung der mechanistischen Philosophie. Er beschäftigt sich mit dem „neuen Mechanismus“, d. h. mit jener Strömung innerhalb der zeitgenössischen Wissenschaftsphilosophie und Philosophie der Biologie, die ihr Augenmerk auf die genaue Bedeutung von Mechanismen im Rahmen der Funktionsweise von biologischen Organismen richtet (z. B. dem Mechanismus der Signalübertragung in Nervenzellen, oder dem Mechanismus der Zellatmung in Mitochondrien, oder dem Mechanismus der entwicklungsbiologischen Segmentierung eines Insekts, usw.). Wie der Beitrag zeigen soll, unterscheidet sich der neue Mechanismus vom alten hauptsächlich dadurch, dass er der ganzen Komplexität von biologischen Systemen, wie sie im Lauf der Evolution entstanden sind, angemessen Rechnung trägt.

Teil II: Der alte und der neue Mechanismus, Naturgesetze und Komplexität in der Wissenschaftsphilosophie des 20. Jahrhunderts

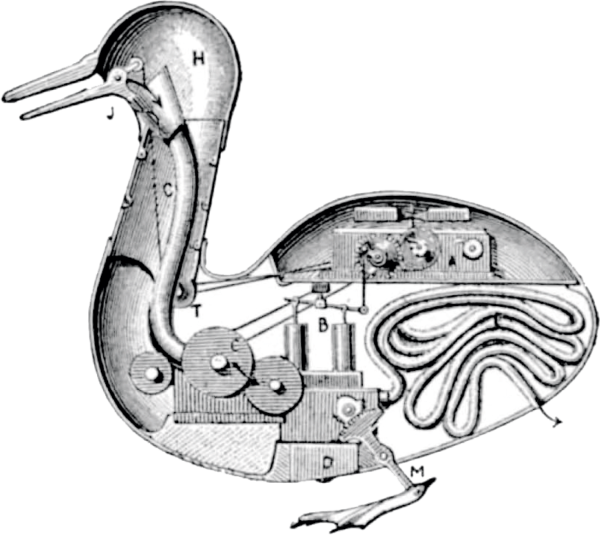

Im ersten Teil dieses Beitrags wurde es zwischen zwei Bedeutungen unterschieden, die der Ausdruck „Mechanismus“ im 17. Jahrhundert annimmt: Einerseits kann sich der Ausdruck auf die Auffassung beziehen, die Welt sei als eine große Maschine zu konzipieren, deren Funktionsweise ohne Rückgriff auf äußere Ursachen erklärt werden soll, wobei allerdings die Frage aufkommt, wer diese Maschine erbaut habe. Andererseits kann der Ausdruck „Mechanismus“ auch einen loseren Zusammenhang mit dem Begriff der Maschine unterhalten und sich auf das neue Weltbild beziehen, das durch das Werk von Galileo Galilei, Kepler und Descartes entwickelt wurde und wonach das Naturgeschehen weniger durch die intrinsischen kausalen Vermögen (die „Seelen“) der Dinge bestimmt ist als durch von oben herab aufoktroyierte Gesetzmäßigkeiten, denen eine als träg konzipierte Materie passiv gehorchen muss.

Beide Auffassungen hatten wichtige Konsequenzen für die Art und Weise, wie im Jahrhundert der naturwissenschaftlichen Revolution die Struktur und die Funktionsweise von organischen Lebewesen konzipiert wurde, wie dies beispielhaft am Werk von Descartes gezeigt worden ist. Denn Descartes vertritt nicht nur die Theorie, dass Lebewesen wie Maschinen modelliert werden sollen, in denen Bewegungen räderwerkmäßig von einer Teilkomponente auf die andere übertragen werden, ohne dass da eine „Seele“ nötig wäre, um die Bewegung voranzutreiben. Eine solche Theorie, wie erwähnt, geht mit der Vorstellung einher, dass ein Handwerker die Maschine planmäßig erbaut und die zweckmäßige Anordnung ihrer Teile bewusst zustande gebracht hat.

Das technologische vs. atomistische Modell

Neben diesem technologischen Modell von Lebewesen vertritt Descartes aber eben auch noch ein atomistisches Modell, das seinen Ausdruck in der entwicklungsbiologischen Theorie der Epigenese findet (J. Elster: „Leibniz et la formation de l’esprit capitaliste“ (Paris, 1975), S. 54ff). Diese besagt, dass Lebewesen durch einen Prozess der Selbstorganisation von kleinen Materieteilchen entstehen, deren Verhalten von den Naturgesetzen diktiert wird, so dass die Herstellung durch einen bewussten und intelligenten Erbauer von vornherein ausgeschlossen wird (anders als im Fall der entgegengesetzten Theorie der Präformation, die organische Lebewesen als vorgeformt statt selbstgeformt konzipiert).

Man könnte nun meinen, dass spätestens seitdem Charles Darwin Mitte des 19. Jahrhunderts seine Theorie der biologischen Evolution durch natürliche Selektion formulierte, die Spannung zwischen den zwei Momenten des Mechanismus – dem „technologischen“ und dem „atomistischen“ – aufgelöst worden sei. Wir brauchen heutzutage nicht mehr auf die Annahme eines bewussten und intelligenten Erbauers zurückzugreifen, um die zweckmäßige Einrichtung von Lebewesen zu erklären, denn organische Anpassungen sind das natürliche Ergebnis des „blinden“ Prozesses der Selektion, durch die Umwelt, von für das Überleben und die Fortpflanzung vorteilhaften Variationen innerhalb einer biologischen Art.

Das Verhältnis zwischen Maschine und Organismus

Die Frage nach dem Verhältnis zwischen Maschine und Organismus und nach dem eigentümlichen Charakter ihrer zweckmäßigen Organisation bleibt allerdings hochaktuell, und es ist das Ziel des vorliegenden Beitrags zu zeigen, dass im Licht dieser Frage bestimmte Aspekte der zeitgenössischen Debatte über Mechanismen in der Philosophie der Biologie beleuchtet werden können, die sonst nicht gerade im Vordergrund stehen, und zwar gerade die Aspekte, auf die Georges Canguilhem in seinem klassischen Aufsatz „Maschine und Organismus“ (1947/1952) (G. Canguilhem: „Maschine und Organismus“ (in: Die Erkenntnis des Lebens, Berlin, 2009) aufmerksam machte.

Zum Einstieg kann daran erinnert werden, dass die Metapher des Organismus als einer Maschine und der natürlichen Selektion als eines – wohl blinden – Uhrmachers noch immer Anwendung findet in den heutigen Debatten. Die Metapher hat übrigens nichts von ihren ursprünglichen sozioökonomischen Konnotationen verloren, die sie schon in der Periode der Manufaktur hatte, als sie Ausdruck der Rationalisierungstendenzen der frühkapitalistischen Produktionsweise war. Besonders deutlich kommen diese Konnotationen in einem für den „neuen Mechanismus“ grundlegenden Aufsatz von Herbert Simon (1916-2001) zum Tragen, nämlich „The Architecture of Complexity“ (1962) (H. A. Simon: The Archtecture of Complexity (in: The Sciences of the Artificial, Cambridge MA, 1982).

Die Parabel von Hora und Tempus

In seinem Aufsatz erzählt Simon die Parabel von Hora und Tempus. Hora und Tempus sind eine Uhrmacherin und ein Uhrmacher, die dem ökonomischen Druck einer warenproduzierenden Marktwirtschaft ausgesetzt sind: Sie müssen nämlich ihre Uhren so effizient wie möglich herstellen, d. h. ohne unnötigen Zeitverlust. In ihrer Komplexität unterscheiden sich die Uhren von Tempus nicht beträchtlich von denjenigen von Hora: Beide stellen Uhren her, die aus ungefähr 1000 Teilkomponenten bestehen, die zusammengesetzt werden müssen.

Worin sich Tempus und Hora unterscheiden, ist in der Effizienz ihrer Produktionsmethoden. Tempus hat seine Uhren so entworfen, dass teilweise zusammengesetzte Uhren wieder in ihre Teilkomponente zerfallen, wenn er in seiner Arbeit unterbrochen wird (z. B. von einer Kundin, die ihn gerade per Telefon anruft, um sich eine neue Uhr zu bestellen). Hora hat dagegen eine modulare Produktionsmethode entwickelt, die ihr ermöglicht, Teilmontagen (subassemblies) aus 10 Teilkomponenten unabhängig voneinander zusammenzusetzen. 10 solcher Teilmontagen bilden eine größere Teilmontage, die mit anderen solchen Teilmontagen wiederum zusammengesetzt werden kann, um die ganze Uhr zu ergeben.

Die heterogene vs. organische Manufaktur

Marx unterscheidet im Manufaktur-Kapitel von „Kapital Band I“ zwei Grundformen der Manufaktur (MEW 23, S. 362-371): In der heterogenen Manufaktur werden selbstständig hergestellte Teilprodukte zusammengesetzt, um das fertige Produkt zu ergeben; in der organischen Manufaktur entsteht hingegen das Endprodukt durch eine Reihenfolge sukzessiver Manipulationen. Man kann da eine gewisse Ähnlichkeit mit den Produktionsmethoden von Hora und Tempus erkennen.

Der Vorteil von Horas Methode ist offensichtlich: Wenn sie durch den telefonischen Anruf eines Kunden in ihrer Arbeit unterbrochen wird, verliert sie nur die Teilmontage, an der sie gerade arbeitet, was eine beträchtliche Zeitersparnis gegenüber Tempus darstellt. Die ökonomischen Folgen sind auch voraussichtlich: „Hora prospered, while Tempus became poorer and poorer and finally lost his shop.“ (Simon, S. 200)

Die Evolvierbarkeit biologischer Organismen

Simon erzählt diese Parabel, um die Struktur und Produktionsweise von Uhren in Analogie zu setzen mit dem hierarchischen Aufbau, den man bei biologischen Organismen beobachtet (mit den verschiedenen Ebenen Moleküle – Makromoleküle – Organelle – Zellen – Gewebe – Organe – Organismus), und der Wirkungsweise der natürlichen Selektion, die diesen Aufbau erklären soll. Der marktwirtschaftliche Druck auf die Produktionsmethoden von Uhrmachern und Uhrmacherinnen entspricht dem Druck der natürlichen Selektion auf den Aufbau von biologischen Organismen: Vorteilhaft werden sich unter einem solchen selektiven Druck jene biologischen Strukturen erweisen, die dank ihrem hierarchischen und modularen Charakter die Evolution eines Teils des Organismus relativ unabhängig machen von der Evolution anderer Teile und somit die Evolvierbarkeit des Organismus steigern.

Simon selbst verwendet nicht diesen Ausdruck, der Sache nach meint er aber genau das, was die heutige Biologie und Philosophie der Biologie mit Evolvierbarkeit meinen. Grundlegend für die neuen Debatten ist das Paper von G. Wagner, L. Altenberg, „Complex Adaptations and the Evolution of Evolvability“ (in Evolution, 50, 1996). Siehe zu den Ursprüngen dieses Begriffs auch das Werk von Rupert Riedl.

Die Architektur der Komplexität als evolutionärer Prozess

Wenn also der „alte Mechanismus“ von Descartes und seinen Nachfolgern außerstande war, die zweckmäßige Anordnung der Teile einer Biomaschine anders als durch das Werk eines göttlichen Handwerkers zu erklären, so beabsichtigt der „neue Mechanismus“ von Herbert Simon und seinen Nachfolgern programmatisch, die „Architektur der Komplexität“ von Biomaschinen auf die Wirkung der natürlichen Selektion zurückzuführen.

Welche Konsequenzen hat aber diese Analogisierung der Wirkungsweise der natürlichen Selektion mit den Rationalisierungsanforderungen einer auf technologischen Fortschritt angewiesenen Produktionsweise? Handelt es sich dabei bloß um eine unschuldige Metapher oder hat sie noch weiterreichenden Implikationen für die Konzipierung selbst der Komplexität von Lebewesen? Ist eine solche Analogisierung wirklich legitim oder verleitet sie nicht eher zu irreführenden Schlüssen über die Natur der inneren Verfasstheit und Funktionsweise von biologischen Organismen? Und wie sind biologische Mechanismen genau zu modellieren in Organismen, deren Komplexität ein Ergebnis evolutionärer Prozesse ist?

Die Funktionsweise von Biomaschinen als neuer Anthropomorphismus

Das sind die Fragen, denen Canguilhem in seinem schon erwähnten Aufsatz über Maschine und Organismus nachgeht. Wie dies im ersten Teil des Beitrags schon gezeigt wurde, hebt Canguilhem bei Descartes vor allem den Aspekt hervor, dass die maschinelle Funktionsweise von Lebewesen den „politischen“ Anthropomorphismus eines befehlenden Willens, der in das Räderwerk der Biomaschine kausal eingreifen würde, entbehrlich macht, wobei die maschinelle Einrichtung der bêtes-machines einen neuen Anthropomorphismus veranlasst, nämlich den „technologischen“ eines äußeren Erbauers: Die Teleologie wird „am Ausgangspunkt“ wieder eingeführt. (Canguilehm, S. 206)

Die Entbehrlichkeit von seelischen Vermögen, um die Funktionsweise von Biomaschinen zu erklären, hängt damit zusammen, dass diese Maschinen als Uhrwerke konzipiert werden, in denen die Bewegungsübertragung von einem Rad auf das andere wegen der Härte und der Starrheit dieser Räder äußerst präzis ist.

Dabei soll allerdings nicht vergessen werden, dass Descartes auch ein alternatives Modell von Maschinen kennt, um seine Tiere zu konzipieren: Das Modell der hydraulischen Maschinen, deren Teile eben weich und feucht sind und somit besser die biologische Wirklichkeit widerspiegeln als das Räderwerk einer Uhr.

Die epigenitische Selbstorganisation biologischer Lebewesen

Dieses zweite Modell von Maschinen spielt eine wichtige Rolle in jenen Texten von Descartes, in denen er die epigenetische Theorie der Selbstorganisation von Lebewesen vertritt. Dass Canguilhem das hydraulische Modell bei Descartes nur am Rande behandelt, rührt daher, dass er sich bewusst ist, dass die konsequente Durchführung des Gedankens, dass Lebewesen aus weichen und feuchten Teilen bestehen und somit nicht dieselbe Präzision besitzen wie die eines Räderwerks, dabei aber durch epigenetische Selbstorganisation entstehen können, das technologische Modell selbst von Tieren als Maschinen zum Sprengen bringt. Wenn Canguilhem nämlich auf seine eigene Auffassung vom Verhältnis zwischen Maschine und Organismus zu sprechen kommt, macht er gerade auf den Unterschied aufmerksam, dass man in einem Organismus „Phänomene der Selbstkonstruktion, Selbsterhaltung, Selbstregulierung und Selbstwiederherstellung“ beobachtet. (Canguilhem, S. 211)

Solche Phänomene wären unmöglich, wenn Organismen Maschinen wären, deren Komponenten derart hart und starr sind, dass sie keine Flexibilität ermöglichen. Die Flexibilität, die Organismen gegenüber Maschinen aufweisen, scheint sogar zu beinhalten, dass organische Komponenten weniger zweckmäßig sind als mechanische:

„Man würde gerne sagen, dass eine Maschine stärker zweckbestimmt ist als ein Organismus, weil ihre Zweckmäßigkeit starr und eindeutig ist. Eine Maschine kann keine andere Maschine ersetzen. Je begrenzter die Finalität und je enger der Toleranzbereich ist, desto verhärteter und deutlicher erscheint die Finalität. Im Organismus beobachtet man hingegen, und auch das ist zu bekannt, um darauf zu insistieren, eine Vikarianz der Funktionen und eine Polyvalenz der Organe. Zweifelsohne sind die Vikarianz der Funktionen und die Polyvalenz der Organe nicht absolut, doch sind sie im Verhältnis zu denen der Maschine um so viel beträchtlicher, dass sich im Grunde der Vergleich nicht aufrechterhalten lässt.“ (Canguilhem, S. 213)

Die Vikarianz der Funktionen vs. der Polyvalenz der Organe

Vikarianz der Funktionen bedeutet, dass die Funktion eines bestimmten organischen Teils auch von einem anderen übernommen werden kann, wenn der erste beschädigt wird. Dies kann z. B. bei bestimmten Gehirnschäden vorkommen, wie dies Canguilhem von seiner Auseinandersetzung mit dem Werk von Kurt Goldstein wusste. (K. Goldstein. „Der Aufbau des Organismus: Einführung in die Biologie unter besonderer Berücksichtigung der Erfahrungen am kranken Menschen“ (Haag, 1934)

Polyvalenz der Organe bedeutet hingegen, dass derselbe Organ auch mehrere Funktionen ausüben kann – Canguilhem erwähnt den Fall des Magens, der neben Verdauungsfunktionen angeblich auch bei der Blutbildung eine wichtige Rolle spielt. Die Flexibilität und Anpassungsfähigkeit von Lebewesen – die Canguilhem auch als ihre Normativität bezeichnet – unterscheiden diese entschieden von Maschinen, die keine neuen Normen erzeugen können:

„Ein Organismus hat also mehr Handlungsspielraum als eine Maschine. Er verfügt über weniger Finalität und mehr Potentialitäten. Die aus Berechnung erzeugte Maschine verifiziert die Normen der Berechnung, das heißt die rationalen Normen der Identität, der Konstanz und der Prognose, während der lebendige Organismus nach empirischen Gesetzen verfährt. Das Leben ist Erfahrung; das heißt Improvisation und Nutzung von Gegebenheiten; es ist in jedem Sinn ein Versuch. Daher rührt jene gewichtige und sehr oft verkannte Tatsache, dass das Leben Monstrositäten zulässt. Es gibt keine Monstermaschinen. […] Denn Monster sind Lebewesen.“ (Canguilhem, S. 215f)

Die Evolvierbarkeit hierarchisch-modular aufgebauter Organismen als epigentische Theorie der organischen Entwicklung

Wenn wir uns vergegenwärtigen, dass Herbert Simon die gesteigerte Evolvierbarkeit von hierarchisch-modular aufgebauten Organismen anhand der Parabel des Uhrmachers und der Uhrmacherin veranschaulichte, können wir feststellen, dass Canguilhem gerade dieselbe Fähigkeit zur erfolgreichen Hervorbringung evolutionärer Neuigkeiten thematisiert, allerdings durch die explizite Zurückweisung der technologischen Analogie zwischen Organismus und Maschine: Wenn Organismen evolutionär erfolgreich sind in der Erzeugung neuer Normen und in der Erfindung neuer Anpassungen, so wird das nicht bloß durch einen hierarchisch-modularen Aufbau bewirkt, sondern durch die robuste Flexibilität desselben, die durch Vikarianz der Funktionen und Polyvalenz der Organe zustande kommt.

Wenn wir uns jetzt der zeitgenössischen Debatte über biologische Mechanismen zuwenden, können wir feststellen, dass Canguilhems Kritik am „technologischen“ Modell von Organismen wichtige Konsequenzen auch für das alternative „atomistische“ Modell hat, dem wir schon bei Descartes begegnet sind. In der Tat könnte man zunächst denken, dass die durch die biologische Evolution bewirkte robuste Flexibilität und normsetzende Erfindungskraft von Lebewesen im Einklang stehen würde mit den Prämissen der epigenetischen Theorie der organischen Entwicklung, wie man sie eben auch schon bei Descartes findet: Nach dieser Theorie sind Organismen das Ergebnis eines Selbstorganisationsprozesses von kleinen materiellen Teilchen, deren Verhalten durch allgemeine Naturgesetze diktiert wird, ohne dass dabei der Rückgriff auf intrinsische kausale Dispositionen der Materieteilchen selbst nötig wäre.

Die Rolle der allgemeinen Naturgesetze

Bei näherem Hinsehen zeigt es sich allerdings, dass die Prämissen, auf denen das „atomistische“ Modell beruht, nicht dieselben sind wie die vom „neuen Mechanismus“. Zum Ersten kann man nämlich beobachten, dass die Zerlegung eines komplexen organischen Ganzen in seine Teilkomponenten nicht so unproblematisch ist, wie dies die reduktionistischen Annahmen der modernen Naturwissenschaft glauben lassen würden, und zwar gerade aufgrund jener von Canguilhem als „Vikarianz der Funktionen“ und „Polyvalenz der Organe“ beschriebenen Phänomene.

Zweitens ist auch die Rolle von allgemeinen Naturgesetzen, die das Verhalten von materiellen Teilchen diktieren würden, in der Wissenschaftsphilosophie des 20. Jahrhunderts problematisiert worden, und in einem für den „neuen Mechanismus“ als Referenz geltenden Paper aus dem Jahr 2000 definieren die Philosophen Machamer, Darden und Craver „Mechanismen“ ohne jedweden Bezug auf den Begriff des Naturgesetzes:

„Mechanisms are entities and activities organized such that they are productive of regular changes from start or set-up to finish or termination conditions.“(P. Machamer, L. Darden, C. F. Craver, Thinking about Mechanisms (in Philosophy of Science, 67, 2000), S. 3)

Die nicht-eindeutige Zerlegbarkeit komplexer, organischer Systeme

In Bezug auf den ersten hervorgehobenen Aspekt, nämlich die nicht eindeutige Zerlegbarkeit eines komplexen organischen Ganzen in seine Teilkomponenten, bildet der schon oben erwähnte Aufsatz von Herbert Simon den Ausgangspunkt der Debatte. Nachdem er nämlich die hierarchische (modulare) Architektur von komplexen Systemen (und zwar nicht nur von biologischen Systemen, sondern auch physikalischen, sozialen und symbolischen) eingeführt hat, macht Simon auf eine wichtige Eigenschaft solcher hierarchischen Systeme aufmerksam, die er als deren Nahezu-Zerlegbarkeit (near-decomposability) bezeichnet. (Simon, S. 209ff)

Dass hierarchische Systeme nahezu zerlegbar sind, bedeutet laut Simon, dass die Interaktionen zwischen den Teilen innerhalb einer Komponente des Systems (intracomponent linkages) stärker sind als die Interaktionen zwischen unterschiedlichen Komponenten (intercomponent linkages). Obwohl dies im Hinblick auf den Aufbau von biologischen Systemen sehr plausibel klingt, erweist sich diese Nahezu-Zerlegbarkeit empirisch nicht so leicht zu fassen, wie man zunächst meinen könnte.

Der Biologe Stuart A. Kauffman und der Wissenschaftsphilosoph William Wimsatt wiesen in den 1970er Jahren darauf hin, dass die empirische Zerlegung eines komplexen Systems in seine Teilkomponenten unterschiedlich sein kann, je nachdem, was die spezifische Fragestellung und die konkreten Interessen sind, die den Forscher oder die Forscherin leiten. (S. A. Kauffman: „Articulation of Parts Explanation in Biology and the Rational Search for Them“ (in Proceedings of the Biennial Meeting of the PSA, 1970); W. Wimsatt. „Complexity and Organization“ (in Proceedings of the Biennial Meeting of the PSA, 1972)

Wenn man z. B. einen mehrzelligen Organismus zerlegen und seine Zellen gruppieren will, so bieten sich mindestens zwei Kriterien dar, die zu unterschiedlichen Resultaten führen, denn die Gruppierung nach Zelltypen, die bestimmte Gene exprimieren und somit spezifische Funktionen erfüllen, entspricht nicht eins zu eins der Gruppierung nach embryologischer Herkunft (die angibt, aus welchem Keimblatt eine bestimmte Zelle stammt, ob aus dem Entoderm, aus dem Mesoderm oder aus dem Ektoderm). Außer dieser Schwierigkeit hinsichtlich der empirischen Zerlegung eines komplexen Ganzen in seine Teilkomponenten weist Wimsatt auch darauf hin, dass die Zusammensetzung der Teilkomponenten deren Funktionsweise nicht unverändert lässt, da die Zusammensetzung einen nicht-aggregativen Charakter hat:

„The optima and conditions of stability for a system of aggregated parts are in general different in a non-aggregative way from the optima and conditions of stability for its parts taken in isolation.“ (Wimsatt, S. 76)

Die kontextuelle Interaktion der Komponenten eines komplexen Systems als emergentes Phänomen

Obwohl die Interaktionen zwischen den Komponenten eines komplexen Systems schwächer sein mögen als die Interaktionen innerhalb jeder einzelnen Komponente, führen sie doch zur Emergenz von neuen systemischen Eigenschaften, die u. a. jene von Canguilhem als „Vikarianz der Funktionen“ und „Polyvalenz der Organe“ beschriebenen Phänomene möglich machen. Entgegen der „alt-mechanistischen“ Annahme, dass das Verhalten des Ganzen sich aus der Summe des Verhaltens der isolierten Teile ergibt, machen Wimsatt und Kauffman geltend, dass das Verhalten und die Wirkungsweise der Teile selbst moduliert werden vom Kontext des komplexen Systems, das sie konstituieren.

William Bechtel und Robert C. Richardson bezeichnen in ihrem Buch „Discovering Complexity“ (1993/2010) diese Variante des „neuen Mechanismus“ als emergenten Mechanismus (emerging mechanism) oder als Konnektionismus. (W. Bechtel, R. Richardson: „Discovering Complexity“ (Cambridge MA, 2010), S. 199. Bechtel und Richardson widmen dieser reifsten Form des neuen Mechanismus den dritten Teil ihres Buchs)

Als Beispiel für den nicht-linearen Charakter der Interaktionen zwischen den Teilen eines komplexen organischen Systems kann man die von Stuart Kauffman selbst untersuchten regulatorischen genetischen Netzwerke (S. A. Kauffman: „The Origins of Order: Self-Organization and Selection in Evolution“ (New York, 1993); Bechtel, Richardson, S. 223-227) anführen, in deren Rahmen die phänotypischen Auswirkungen eines regulatorischen Gens (das als Enhancer oder als Inhibitor für die Expression anderer Gene fungiert) nicht sosehr von dessen intrinsischer biochemischer Spezifizität abhängen als von der Position des regulatorischen Gens im gesamten Netzwerk. Gerade diese Flexibilität hinsichtlich der phänotypischen Auswirkungen eines regulatorischen Gens macht sich die Evolution zunutze, um neue entwicklungsbiologische Programme (d. h. neue Baupläne und Modifikationen derselben) zu „erfinden“ („Evo-Devo“).

Die soeben hervorgehobene Kontextabhängigkeit der Wirkungsweise der Komponenten eines komplexen organischen Systems betrifft auch den zweiten oben erwähnten Aspekt des neuen Mechanismus, nämlich seine Relativierung der Rolle von allgemeinen Naturgesetzen in Bezug auf biologische Mechanismen. Die Entwicklung des „neuen Mechanismus“ verläuft in der Tat parallel zur Entwicklung jener Strömung in der Wissenschaftsphilosophie, die im Unterschied zu den neupositivistisch geprägten Ansätzen, die in den 1950er/1960er Jahren populär waren (Carl Gustav Hempel, Paul Oppenheim, Ernest Nagel), eine gegenüber der Rolle von allgemeinen und modal notwendigen Naturgesetzen in der wissenschaftlichen Erklärung eher skeptische Haltung annimmt.

Das deduktiv-nomologische Modell des Neo-Positivismus

Während die Neupositivisten das deduktiv-nomologische Modell (DN-Modell) der wissenschaftlichen Erklärung entwickelten – nach welchem allgemeine und modal notwendige Naturgesetze dazu dienen, aus bestimmten Anfangsbedingungen ein bestimmtes Ereignis oder einen bestimmten Zustand abzuleiten –, betonen Leute wie Nancy Cartwright, Ian Hacking oder auch Stephen Mumford eher die Rolle von singulären kausalen Beziehungen zwischen materiellen Entitäten, um Ereignisse oder Zustände der physikalischen Wirklichkeit zu erklären. (N. Cartwright: „How the Laws of Physics Lie“ (Oxford, 1983); I. Hacking: „Representing and Intervening“ (Cambridge, 1983); S. Mumford, Laws in Nature (London, 2004)

Laut Cartwright stellen Naturgesetze abstrakte Idealisierungen dar, die die kausalen Dispositionen (capacities) von physikalischen Entitäten nur dann widerspiegeln, wenn man diese Dispositionen unter idealen Bedingungen (also in Absehung von der Wechselwirkung mit anderen Dispositionen) betrachtet. Wenn man aber das Verhalten dieser Entitäten in einem realistischeren Zusammenhang zu erklären versucht, in dem mehrere Kräfte wirken, dann verlieren Naturgesetze ihr explanatory power, denn nicht immer lassen sich die Wirkungen dieser Kräfte linear addieren (wie z. B. im Fall der linearen Addition von Vektoren für die Gravitations- und für die Coulomb-Kraft). Im Fall von thermodynamischen Gradienten (Temperatur, Konzentration, elektrische Ladungen) ist eine solche Addition z. B. nicht möglich, wie dies die Schwierigkeiten zeigen, mit denen Physiker und Physikerinnen sich konfrontiert sehen, wenn sie versuchen, die nicht-linearen Wechselwirkungen dieser Gradienten durch die sogenannte Onsager-Theorie zu modellieren. (Cartwright, S. 64f)

Diese Überlegungen sind hoch relevant auch gerade für die Rolle von Naturgesetzen in Bezug auf biologische Mechanismen. Wie erwähnt, definieren Machamer, Darden und Craver in ihrem Paper aus dem Jahr 2000 („MDC-Paper“) Mechanismen ohne jedweden Bezug auf Naturgesetze. Dabei ist die Frage legitim, wie denn die „regular changes from start or set-up to finish or termination conditions“ durch die Entitäten und Aktivitäten zustande kommen können, die den Mechanismus konstituieren.

Die Kontextabhängigkeit komplexer Systeme am Beispiel des Aktionspotentials von Nervenzellen

Marcel Weber, der die Mechanismus-Konzeption vom MDC-Paper anhand des Beispiels der Übertragung eines Aktionspotentials entlang des Axons einer Nervenzelle veranschaulicht und dabei auf die verschiedenen Entitäten (Ionen, Membran, Ionenkanäle, Na+/K+-Pumpe) und deren Aktivitäten eingeht, die den Mechanismus konstituieren (M. Weber: „Philosophy of Experimental Biology“ (Cambridge, 2005), S. 21ff), macht auch darauf aufmerksam, dass die neurobiologische Forschung doch auch auf Gesetzmäßigkeiten rekurriert, um das Verhalten der Ionen zu erklären.

Insbesondere die Nernst-Gleichung spielt eine wichtige Rolle in der Erklärung des Gleichgewichtspotentials für ein bestimmtes Konzentrationsverhältnis von einer spezifischen Spezies dieser Ionen. Wie Weber selbst erwähnt, handelt es sich bei der Nernst-Gleichung um ein thermodynamisches Gesetz, das das Verhalten von einer großen Menge materieller Teilchen bestimmt, ohne große Aufmerksamkeit auf die kausalen Vermögen einzelner Teilchen zu schenken. (Weber, S. 32) Laut Weber beinhaltet das, dass die Konzeption von Gesetzen, die Cartwright vertritt, für die Nernst-Gleichung nicht gilt. (Weber, S. 31)

Aber Cartwright, wie gesehen, beruft sich explizit auf die Probleme, die bei der Aufstellung von Gesetzen für thermodynamische Systeme auftauchen, um geltend zu machen, dass solche Gesetze das Verhalten der Materieteilchen nur annäherungsweise erklärt, denn gerade in solchen Systemen wird die kontextabhängige Natur der Äußerung der kausalen Vermögen der Teilchen offenbar.

Gerade im Fall der Erklärung der Übertragung des Aktionspotentials entlang einer Nervenzelle wird diese Kontextabhängigkeit manifest: Da in Nervenzellen das Gleichgewichtspotential durch mehrere Ionen (K+, Na+ und Cl–) bestimmt wird, müssen Neurobiologen eigentlich auf eine komplexere Variante der Nernst-Gleichung rekurrieren, nämlich auf die Goldmann-Gleichung, die das Gleichgewichtspotential für ein Verhältnis mehrerer Ionen angibt. (Siehe z. B. D. Purves (u. a.), Neuroscience (New York, 2018), S. 42f) Und obwohl die Goldmann-Gleichung eine komplexere Situation als die Nernst-Gleichung beschreibt, handelt es sich dabei auch wiederum um eine idealisierte Situation, die die reale Komplexität eines biologischen Systems nur annährungsweise erfasst. Wenn also die biologische Forschung, wie von Weber richtigerweise angemerkt, in ihren Erklärungen in der Tat auch auf Gesetzmäßigkeiten zurückgreift, so scheinen diese Gesetzmäßigkeiten den allgemeinen und modal notwendigen Charakter, den sie für das DN-Modell hatten, doch eingebüsst zu haben.

***

Das Fazit

Zum Schluss dieses zweiteiligen Beitrags über den alten und den neuen Mechanismus können die allgemeinen Ergebnisse unserer Auseinandersetzung folgendermaßen zusammengefasst werden: Während der alte Mechanismus zwischen zwei grundsätzlich unvereinbaren Konzeptionen schwankte – einerseits die „technologische“ Konzeption der Welt und insbesondere der sie bewohnenden Lebewesen als Maschinen, die von einem bewussten und intelligenten Erbauer entworfen wurden, und andererseits die „atomistische“ Konzeption, die die Welt und die Lebewesen aus dem Zusammenspiel von Materieteilchen entstehen lässt, deren Verhalten von allgemeinen Naturgesetzen diktiert wird –, ist der neue Mechanismus durch die evolutionäre Sicht geprägt, die im 19. Jahrhundert entwickelt wurde.

Obwohl man zunächst meinen könnte, dass dadurch die „atomistische“ Konzeption zum Sieg gegenüber der „technologischen“ verholfen wurde, sollte der vorliegende Beitrag gerade gezeigt haben, dass sowohl die reduktionistische Annahme, komplexe Systeme seien eindeutig in ihre Teilkomponenten zerlegbar, wie auch das neupositivistische Postulat, das Verhalten von physikalischen Teilchen sei durch allgemeine und modal notwendige Naturgesetze bestimmt, durch die Komplexität biologischer Mechanismen problematisch geworden sind. Durch die Berücksichtigung dieser Komplexität sind aus dem starren Verhalten der kartesischen bêtes-machines die flexiblen und evolvierbaren Systeme erwachsen, die die heutige Biologie ins Zentrum ihrer Forschung gestellt hat.

https://orcid.org/0009-0008-6932-2717

https://orcid.org/0009-0008-6932-2717

Die Wissenschaft des Lebendigen macht dieselben Fehler wie seit jeher. Legen Sie einen Käfer neben einen Stein und beschreiben Sie den Unterschied. Der Physiker wird keinen Unterschied feststellen, der Biologe schon. Aber er benutzt dafür die Sprache der Physik, was wie ein Sprachfehler anmutet. Die Beschreibung der Physik ist quasi zweidimensional, Richtung und Zeit. Die Biologie braucht aber eine dritte Dimension, die Evolution von Emergenzen. Der Grund für diesen Mangel ist ein methodologischer, die Verwechslung von Analyse und Reduktion.

Während man in der Physik jene zweidimensionale Komplexität jederzeit hinsichtlich ihrer Bausteine analysieren und sie auf diese reduzieren kann (Reduktionismus), gelingt dies in der Biologie nicht, ohne die dritte Dimension zu zerstören. Die Analyse der Bausteine ist dort das eine, das andere ist die Reduktion auf Prinzipien. Daher gelingt es nicht, Begriffe wie Selbstorganisation naturwissenschaftlich zu füllen.

Fragt man also nach den Prinzipien und nicht nach den Bausteinen, so stellt sich etwa bei dem Begriff der Selbstorganisation die Frage, was bringt ein biologisches System dazu, sich selbst zu organisieren. Schließen wir die Organisation von außen aus, bliebe die Organisation von innen. Wenn es nicht die Bausteine sind (Atomismus, Physikalismus), was ist es dann? Die einzig mögliche logische Antwort ist, es muss ein Steuerungssystem geben. Ich habe versucht dieses Steuerungssystem auf Basis von sog. Metastrukturen darzustellen (https://www.dr-stegemann.de).

Wie aber ‚weiß‘ ein biologisches System, wohin es evolvieren soll, um zu überleben? Kann man es auf ein stochastisches (und damit physikalisches) System reduzieren? Es würde dem internen Steuerungssystem widersprechen. Ich gehe davon aus, dass biologische Systeme innerhalb eines Phasenraumes Mutationen generieren, aber nicht stochastisch, sondern valenzbasiert. Damit meine ich, dass biologische Systeme nur solche Mutationen bilden (können), die a) ihren Systemeigenschaften entsprechen und b) dem ‚Aufforderungscharakter‘ sowie dem Möglichkeitsraum gerecht werden, welche die Umwelt generiert (https://www.dr-stegemann.de/was-ist-leben/).