Table of Contents

Gastbeitrag von Yervant Kulbashian ():

| Original text click on the flag: |

Einleitung

Der hier erschiene Gastbeitrag stammt von Yervant Kulbashian, den ich über Social Media kennen und schätzen gelernt habe.

Yervant arbeitet als Engineering Manager bei einer KI-Plattform für die kanadische Firma „Kindred“, die zur „Ocado-Group“ gehört. Nur zur Information:

„Kindred wurde 2014 gegründet und ist ein Unternehmen für Robotik und künstliche Intelligenz (KI), das Roboter zur Lösung von Problemen in der realen Welt entwickelt. Das Unternehmen hat es sich zur Aufgabe gemacht, das Leben menschlicher Arbeitskräfte mit der Leistung von KI-Robotern zu verbessern. Die Spitzentechnologie von Kindred bildet die Grundlage für eine Reihe von proprietären Plattformen, darunter CORE mit AutoGrasp™, die für den autonomen Betrieb von Robotern in dynamischen Umgebungen entwickelt wurden. Das Team aus Wissenschaftlern, Ingenieuren und Geschäftsleuten hat einen neuen Standard für das Reinforcement Learning von Robotern gesetzt. Das Unternehmen hat seinen Sitz in San Francisco und Toronto und gehört zur britischen Ocado Group plc.“ (https://www.apollo.io/people/Yervant/Kulbashian/54a916287468693399953e0c).

Und genau dieses Reinforcement Learning als „autonomer Betrieb von Robotern in dynamischen Umgebungen“ war der Auslöser zur einer sehr produktiven Korrespondenz zu meinem zuvor veröffentlichten Essay „Das System braucht neue Strukturen – nicht nur für/gegen die Künstliche Intelligenz (KI)„. Der Schwerpunkt unseres interessanten Austausches, den wir später auch in unserer „Zoomposium-Tafelrunde“ fortgesetzt haben, lag hauptsächlich auf dem „Subjekt-Objekt-Konzept“ für „maschinelles Bewusstsein“ und den Möglichkeiten einer symbolischen Repräsentation oder Implementation von menschlicher Sprache auf Maschinen und den hierbei auftretenden logischen Problemen.

In diesem Zusammenhang hatte Yervant bereits im September 2022 seine Artikel zur Sprach-Implementation auf Maschinen veröffentlicht, die im Zusammenhang mit ChatGPT und den Möglichkeiten zur Implementation oder Repräsentation von menschlicher Sprache allerdings eine ganz neue Perspektive und Aktualität erhalten. Die Essays zeigen aber auch sehr deutlich, dass ChatBots momentan noch nichts anderes sind als sehr kluge, „sprechende Papageien„, aber noch sehr weit von semantischen Konzepten der Sprache, geschweige denn bewussten Verwendung, entfernt sind.

Yervant hat sich freundlicherweise bereit erklärt seine 3 Artikel zu dieser Thematik auch bei mir zu veröffentlichen, die ich nun sukzessive online stelle. Um sie meiner deutschen Leserschaft zugänglich zu machen, habe ich sie ins Deutsche übersetzt. Der Originaltext ist aber unten zur Verfügung gestellt.

Zu dem weiterführenden Thema „AC/DC“ (nur als bonmot gemeint 😉 oder „Artificial Consciousness/Digital Consciousness„ sind allerdings noch weitere Projekte geplant, auf die ich hier schon einmal prospektiv hinweisen möchte. Aber jetzt soll Yervant oder besser gesagt „die KI zur Sprache kommen“:

Übersetzung: „Der grüne Schwan – Über die Nützlichkeit der Logik in der KI“

Abstrakt

Alle modernen logischen KIs behandeln Symbole und Logik¹ als fest verdrahtete Prozesse, die automatisch die Überzeugungen einer KI konstruieren. Beim Menschen hingegen wird die Fähigkeit, Logik zu verwenden, im Laufe des Lebens schrittweise erlernt. Außerdem sind Symbole und Logik beides Artefakte der Kommunikation. Sie entstehen, werden validiert und durch Interaktionen mit anderen Menschen verfeinert.

Zwei wichtige Konsequenzen für die KI sind, dass

- die Verwendung von Logik immer optional ist; sie geschieht nicht automatisch, und

- die Entscheidung, wann und wie die formale Logik verwendet wird, ist sozial motiviert.

All dies bedeutet, dass eine KI logische Konzepte und Axiome von Grund auf lernen muss, um die Logik adaptiv zu nutzen und erfolgreich in einen bestimmten Kontext einzuordnen.

Um zu sehen, warum, lassen Sie uns mit einem Beispiel beginnen: dem grünen Schwan.

Das Problem der Vorhersageeinordnung

In vielen KI-Texten wird davon ausgegangen, dass die Informationslage begrenzt ist – ohne dass diese Annahme ausdrücklich erwähnt wird. – Konzepte der logischen KI, McCarthy

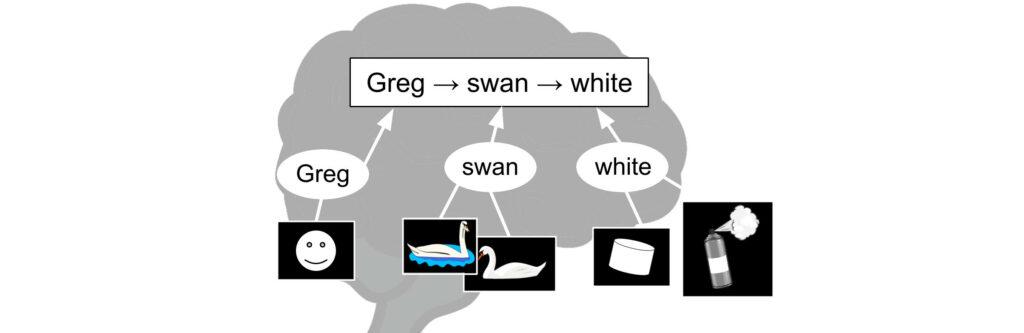

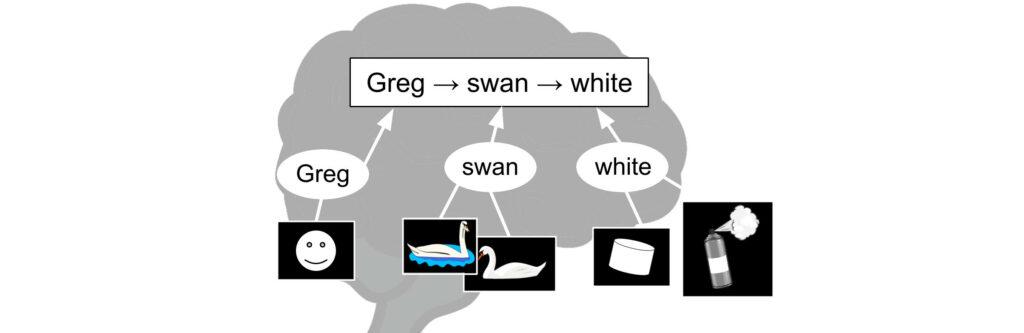

Stellen Sie sich vor, Sie sollen die Wissensbasis einer KI auffüllen. Ihr Ziel ist es, durch logische Schlussfolgerungen neue Informationen aus vorhandenen Fakten abzuleiten. Als Teil ihres Weltverständnisses bringen Sie der KI bei, dass

Alle Schwäne sind weiß

Dies ist eine einfache logische Aussage, ein so genanntes Prädikat. Für dieses Beispiel nehmen wir an, dass alle Wörter des Prädikats auf den Erfahrungen der KI beruhen. Die KI kann einen Schwan und die Farbe Weiß in ihrem Fluss von Sinneseindrücken erkennen².

Aufgrund der obigen Ausführungen kann Ihre KI neue Informationen ableiten:

Greg ist ein Schwan

Deshalb ist Greg weiß

Jede logische KI, die die Worte in den ersten beiden Aussagen verstehen kann, könnte im Prinzip auch die Wahrheit der letzten Aussage herausfinden und bewerten. Ihr Vertrauen in die Schlussfolgerung ist direkt proportional zu ihrem Glauben an die ersten beiden Behauptungen.

Aber was ist mit der ursprünglichen Behauptung, dass alle Schwäne weiß sind? Inwiefern ist sie wahr, so wie sie formuliert ist?

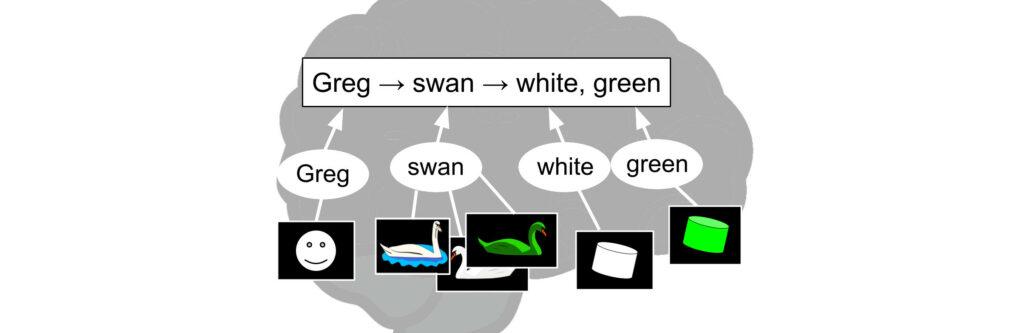

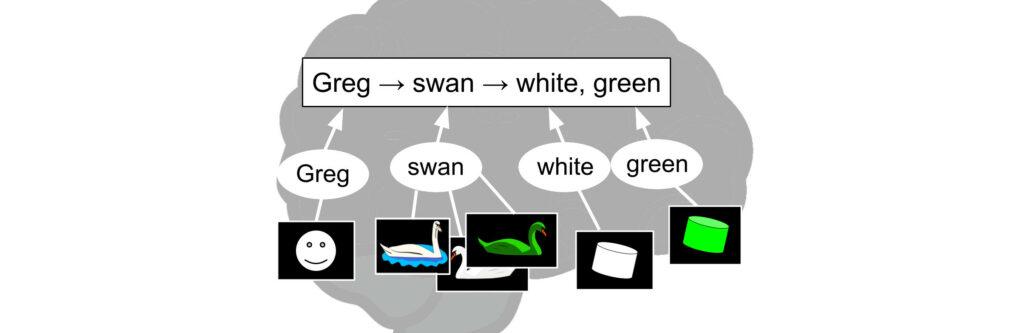

Stellen Sie sich vor, ich würde einen Schwan nehmen und ihn grün anmalen. Dann präsentiere ich ihn der KI.

Ich würde sagen: „Dieser Schwan ist grün besprüht, was bedeutet, dass er nicht weiß ist“. „Das widerlegt das ursprüngliche Prädikat“. Als Programmierer würden Sie vielleicht denken: „Nein, das stimmt nicht. Als ich schrieb, dass alle Schwäne weiß sind, meinte ich, dass

Alle Schwäne sind von Natur aus weiß“.

Die künstliche Intelligenz sieht jedoch einen grünen Schwan, und da das ursprüngliche Prädikat nicht besagt, dass er „von Natur aus weiß“ sein sollte, ändert sie ihre Überzeugung fälschlicherweise in „die meisten Schwäne sind weiß“.

Daraufhin programmieren Sie die KI so um, dass sie die Bedingung enthält, dass sie von Natur aus weiß sein müssen. Als nächstes nehme ich einen Schwan und halte ihn unter ein violettes Licht. Ich sage: „Ich habe die Aussage erneut widerlegt“.

Sie formulieren es noch einmal um: „Als ich sagte, dass alle Schwäne weiß sind, meinte ich, dass

Alle Schwäne sind unter den üblichen Lichtverhältnissen von Natur aus weiß.

Auch diese Nuance ist der KI nicht bekannt. Ihre automatische Inferenzmaschine ist nicht lernfähig genug, um solche Tricks zu berücksichtigen. Sie muss also noch einmal neu trainiert werden.

Ich versuche noch ein paar weitere Tricks: Ich verändere einen bestimmten Schwan chemisch, bis er blau leuchtet, benutze eine gelb getönte Brille, beschreibe fantastische Schwäne aus der Literatur usw. In jedem Fall verfeinern Sie die ursprüngliche Behauptung, um zu präzisieren, was sie eigentlich bedeutet. Schließlich liefere ich einen echten schwarzen Schwan.

„Jetzt ist er widerlegt“, geben Sie zu, und Sie lassen die KI ihre Überzeugungen auf „die meisten Schwäne sind weiß“ umstellen.

Was ist passiert? Sie begannen mit einer scheinbar einfachen Aussage – „alle Schwäne sind weiß“ – doch am Ende hatten Sie eine ganze Welt von Annahmen und versteckten Bedingungen aufgedeckt. Ohne diese war die Aussage nicht wirklich vollständig. Und die Vorbehalte sind umfangreicher als ich beschrieben habe. Purpurlicht und chemische Modifikation sind neuere Erfindungen. Stellen Sie sich vor, wie viele Möglichkeiten es in der Zukunft geben könnte, diese Aussage zu unterlaufen.

Eine solche Unvollständigkeit ist ein Merkmal aller Prädikate; zum Beispiel „alle Menschen sind sterblich“ (was ist mit fiktiven Menschen?), „die Hauptstadt Frankreichs ist Paris“ (nicht in meinem Spiel Civilization V) und „Mary hat keinen Bart“ (wir alle haben feine, unmerkliche Haare, die unseren Körper bedecken). Die expliziten Begriffe des Prädikats sind nur ein Bruchteil der darin enthaltenen Informationen. Worte sind der äußere und keineswegs vollständige Ausdruck eines Komplexes von inneren Annahmen und Absichten.

Während meiner gesamten Interaktion mit der oben genannten KI änderte sich die Bedeutung der Wörter „Schwan“, „sind“ oder „weiß“ nicht; sie blieben stabil und fundiert. Das Prädikat, wie es geschrieben wurde, war immer klar. Das Problem geht also über das klassische Symbol-Grundlagen-Problem hinaus und geht sogar davon aus, dass es gelöst ist. Man könnte dieses neue Problem das „Prädikat-Scoping-Problem“³ nennen.

Damit eine künstliche Intelligenz selbst grundlegende Logik erster Ordnung wirksam auf eine Situation anwenden kann, muss sie auf solche Nuancen und verborgenen Absichten eingestellt sein und die Interpretation von Prädikaten anpassen, wenn neue Fälle auftreten. Andernfalls wird seine Manipulation von Symbolen oberflächlich und naiv sein. Sie wird sich wie eine sozial verkrüppelte Person verhalten, die alles wörtlich nimmt.

Angesichts der Tatsache, dass logische Prädikate so fließend und mehrdeutig interpretierbar sind, stellt sich die Frage, welchen Wert eine KI überhaupt hat, wenn sie sie verwendet.

Logische Prädikate sind normalerweise wertlos

Die [symbolische] Repräsentation geht sowohl dem Lernen als auch dem Schlussfolgern voraus … In einer lokalistischen Repräsentation haben die relevanten Konzepte einen zugehörigen Bezeichner. Dies ist typischerweise eine diskrete Repräsentation – Neurosymbolic A.I., The 3rd Wave

Formale Logik ist nichts, was eine KI „physisch“ bei ihren Interaktionen mit der Welt anwendet. Sie kann Logik nur auf ein mentales Modell der Welt anwenden, auf „Ideen“, die sie aufgrund ihrer Erfahrungen verfeinert hat. Ihr Netzwerk muss zunächst einen wild variierenden Zustrom von Bildern und Tönen in nützliche Muster unterteilen, die ein Objekt, ein Konzept, ein Ereignis oder eine Wahrscheinlichkeitsverteilung von Ereignissen darstellen. Es erstellt ein Modell, mit dem es eine Reihe von Farben beispielsweise als „Stuhl“ oder eine längere Reihe von Farben als „Krieg“ interpretiert. In dem Maße, in dem es neue Darstellungen der Welt lernt, beginnt es, neue Konzepte wie „Steuern“ oder „Relativität“ wahrzunehmen, und wendet die Logik auf diese Konzepte an.

Logisches Denken kann nur auf der Grundlage von klarem, präzisem und verallgemeinertem Wissen umgesetzt werden – Logisches Pre-Training von Sprachmodellen

Da die formale Logik nicht mit vagen Gefühlen oder verschlungenen Begriffen arbeiten kann, müssen ihre „Objekte“ klar definiert sein, wie z. B. Zahlen, Namen von Personen, allgemeine Bilder oder sogar ein Vektor im latenten Raum. Sobald eine KI diese Begriffe definiert hat, besteht die Aufgabe der formalen Logik darin, eine konsistente Reihe von mentalen Beziehungen zwischen ihnen aufrechtzuerhalten, indem sie vorschreibt, welche neuen Informationen sie ableiten kann und welche nicht. Wenn man sich beispielsweise an die Regeln der Logik erster Ordnung hält, ist es nicht erlaubt⁴, A zu behaupten und dann auch das Gegenteil von A zu behaupten.

Damit die formale Logik ihre Aufgabe erfüllen kann, müssen ihre Prädikate also konkrete Symbole sein. Aber wie Sie oben gesehen haben, werden Prädikate zwar als einfache Wörter geschrieben, aber sie beinhalten komplexe Netzwerke von kontextuellen Annahmen. Das bedeutet, dass immer dann, wenn Inkonsistenzen in der expliziten Wissensbasis der KI auftauchen, es möglich ist, dass die verwendeten Begriffe eigentlich nicht dasselbe bedeuten, z. B.

„Weniger ist mehr“

Oder

„Zeit ist Geld“

Diese Aussagen, und eigentlich die meisten Aussagen in Ihrem Kopf (z. B. Metaphern), wären angesichts ihrer expliziten Begriffe schwer logisch aufzulösen. Daher sollten sie „logischerweise“ entweder geändert oder überflüssig gemacht werden. Aber Sie und ich wissen, dass viele dieser scheinbar vagen und unsinnigen Aussagen durchaus einen Sinn haben. Damit eine KI robust ist, sollte sie, wie Sie und ich, immer die Möglichkeit haben, zu entscheiden, ob sie einen expliziten Widerspruch auflöst oder ihn in Ruhe lässt. Die Entscheidung kann keine automatische, fest verdrahtete Funktion sein; sie muss durch den Kontext motiviert sein.

Obwohl die modernen logischen Techniken mit einigem Erfolg die Argumentation bei der Überprüfung mathematischer Beweise und logischer Rätsel erklären können, erklären sie andere Fälle von technischer oder vernünftiger Argumentation nicht sehr detailliert oder plausibel… der Nutzen der Ergebnisse ist umstritten. – Logik und KI, Stanford Encyclopedia

All dies bedeutet, dass eine KI ihre Umwelt nicht unbedingt besser verstehen oder erfolgreicher sein würde, wenn sie die formale Logik strikt auf ihre doch sehr wechselhaften und miteinander verflochtenen Aussagen anwenden würde; nicht erfolgreicher, als wenn sie eine Reihe von scheinbar widersprüchlichen Überzeugungen vertreten würde.

Womit wir wieder bei der ursprünglichen Frage wären: Welchen Nutzen haben Sie – oder eine KI – von der Verwendung formaler Logik?

„Erlaubt“

Die Antwort ist in einem früheren Satz versteckt, in dem ich schrieb: Sie dürfen A nicht behaupten und das Gegenteil davon. Das heißt, Sie dürfen es aufgrund von anderen Leuten.

Bisher wurde in diesem Beitrag davon ausgegangen, dass die formale Logik für eine KI allein von unmittelbarem Nutzen wäre, unabhängig davon, ob andere Agenten in der Nähe sind, und dass sich logische Regeln als Folge dieses Nutzens entwickeln würden. Die gesamte derzeitige KI-Entwicklung setzt voraus, dass ein Agent in jedem Kontext von der Anwendung der Logik profitieren kann, selbst in einem sozialen Vakuum. Dies ist ein Missverständnis, und die daraus resultierende Verwirrung hat sich negativ auf die historische Entwicklung der Logik in der KI ausgewirkt.

Ziel dieser Serie ist es zu zeigen, dass die formale Logik, zumindest beim Menschen, ihre Wurzeln in der sozialen Kommunikation hat. Die so genannten Regeln der Logik sind eine Reihe von Beschränkungen, die Sie lernen, Ihren natürlichen, freieren (nicht logischen) Denkweisen aufzuerlegen. Am wichtigsten ist, dass Sie diese Regeln als Reaktion auf den Druck von anderen Menschen annehmen.

Wir halten es für eine schlechte Sache, inkonsequent zu sein. In ähnlicher Weise kritisieren wir andere, weil sie die logischen Konsequenzen ihrer Überzeugungen nicht zu schätzen wissen. In beiden Fällen geht es darum, dass die eigene Einstellung nicht mit den logischen Regeln übereinstimmt. – Der normative Status der Logik, Stanford Encyclopedia

Ihre Freunde – oder wissenschaftliche Kollegen – suchen nach Kohärenz in dem, was Sie sagen, sowie in den Aussagen, denen Sie alle als Gruppe zustimmen; Aussagen wie „wir treffen uns alle auf dem Parkplatz“ oder „Arten entwickeln sich durch natürliche Selektion“. Auch wenn Sie es zulassen, dass Ihre privaten Gedanken willkürlich und widersprüchlich sind, setzen Sie sich, wenn Sie solche Ungereimtheiten laut aussprechen, dem Vorwurf aus, zu lügen oder bestenfalls nicht zu wissen, wovon Sie reden. Und da Sie andere oft überzeugen wollen – etwas zu tun, etwas zu glauben, auf eine bestimmte Weise zu denken – ist ein gewisses Maß an Selbstkontrolle erforderlich, damit Ihre Worte ernst genommen werden.⁵

In der obigen Diskussion über den grünen Schwan zum Beispiel fühlte sich die Programmiererin gezwungen, die Worte des Prädikats zu ändern, um es zu verdeutlichen. Sie hätte genauso gut sagen können: „Meine Gedanken zu diesem Thema sind konsistent, und das ist alles, was zählt.“ Aber andere können Ihre Gedanken nicht lesen, sie können nur Ihre Worte interpretieren. Im Interesse der Zusammenarbeit verlangt die Welt von Ihnen, dass Sie Ihre frei formulierten Gedanken in ordentliche Kästchen stecken und diese Kästchen mit geraden Linien verbinden.

Der Zweck der Logik besteht darin, den Unterschied zwischen gültigen und ungültigen Argumenten zu kennzeichnen. Ein logisches System für eine Sprache ist ein Satz von Axiomen und Regeln, die dazu dienen, genau die gültigen Argumente zu beweisen, die in der Sprache **statthaft sind** [Hervorhebung von mir] – Modale Logik, Stanford Encyclopedia

Um das klarzustellen: Ich sage nicht, dass die Gesellschaft Ihnen beibringt, wie man Logik benutzt, so wie sie Ihnen beibringt, wie man ein Seil knüpft – etwas, das Sie auch selbst hätten entdecken können. Ich will damit sagen, dass Worte wie „Kohärenz“ oder „Konsistenz“ nur im Kontext sozialer Interaktionen Bedeutung haben⁶ – Sie sind kohärent zu anderen, Sie sind konsistent in Ihrer Sprache. Und auch wenn Sie diese Regeln später vielleicht verinnerlichen und Ihre Gedanken einschränken, liegt ihr Ursprung und ihr Geltungsbereich immer in der zwischenmenschlichen Kommunikation.

Ein selbst erstellter Werkzeugkasten

Ich behaupte nicht, dass die Logik keine „Realität“ hat oder „alles erfunden“ oder „subjektiv“ ist. Ob die Logik Teil der Wirklichkeit ist oder nicht, würde den Rahmen dieser Serie sprengen. Ich glaube sogar, dass die Logik in gewisser Weise Teil der Realität ist. Aber Ihr Gehirn hat nicht direkt mit der Realität zu tun, sondern nur mit den Wahrnehmungen der Realität.

Auch ist es für die Entwicklung von KI nicht relevant, warum andere darauf bestehen, dass Sie logisch sprechen, als ob ihr Beharren von einer allgegenwärtigen Wahrheit über die Welt gesteuert würde⁷. Die Frage, mit der ich mich beschäftige, ist, wie das menschliche Gehirn – und damit auch eine KI – mit der Logik vertraut wird, die entsprechenden Konzepte erstellt oder erwirbt und sie dann anwendet. Mein Ziel ist es nicht, einer KI vorzuschreiben, wie sie denken soll, sondern vielmehr vorherzusagen, was sie zum Thema Logik denken wird und warum; ob die Konzepte eine Entsprechung in der Realität haben oder nicht. Es handelt sich um eine Frage der Erkenntnistheorie der Logik.

Computer zum Lernen zu bringen, wirft zwei Probleme auf – ein erkenntnistheoretisches und ein heuristisches. Das erkenntnistheoretische Problem besteht darin, den Raum der Konzepte zu definieren, die das Programm lernen kann. Das heuristische Problem ist der eigentliche Lernalgorithmus. Das heuristische Problem der Lernalgorithmen ist viel untersucht worden, während das erkenntnistheoretische meist ignoriert wurde. – Konzepte der logischen KI, McCarthy

Bis jetzt hat sich die Mehrheit – möglicherweise die gesamte – KI-Forschung im Bereich der Logik auf zwei Ziele konzentriert:

- die Entdeckung der „richtigen“ Logik, die es zu kodieren gilt, und

- wie eine KI diese Logik bei ihren Überlegungen effektiv anwenden kann.

Fast keine Aufmerksamkeit wurde der Frage gewidmet, wie eine künstliche Intelligenz überhaupt Logik erlernen kann, weil man davon ausgeht, dass sie dies nie tut. Logik wird als Teil der angeborenen Infrastruktur des Geistes betrachtet, was erklären soll, warum sie sich so natürlich und offensichtlich anfühlt. Sie wird also in jede KI als eine angeborene Fähigkeit eingebaut. Alle weiteren Tests, denen die KI unterzogen wird, finden in einem begrenzten Bereich statt, der mit diesen eingebauten Werkzeugen bewältigt werden kann.

In der realen Welt müssen sich die logischen Regeln jedoch ständig an die Interaktion des Agenten mit der Welt anpassen und verändern. Und das bedeutet, dass sie zu einem großen Teil erlernt, ja sogar erfunden werden müssen. Betrachten wir zum Beispiel eine hypothetische KI, die so vorprogrammiert ist, dass sie auf naive Weise Syllogismen ausführt:

Alle A sind B

Alle B sind C

Daher sind alle A gleich C

Wie wir oben gesehen haben, würde eine solche KI bald auf Hindernisse stoßen, die mit der Bedeutung von Wörtern zusammenhängen, wenn sie mit einer Äquivokation konfrontiert wird, z.B.:

All stars are in outer space

Rhianna is a star

Therefore Rhianna is in outer space

Hier zeigt sich ein Manko der Verwendung von Symbolen: Ein konkretes Symbol kann viele Dinge bedeuten. Man könnte vermuten, dass dieses Problem dadurch gelöst werden kann, dass man sich auf die Bedeutung der Wörter konzentriert und nicht auf die Wörter selbst. Man könnte also versuchen, ein Homonym wie „Stern“ in verschiedene Symbole auf der Grundlage ihrer Bedeutung aufzuteilen – Star_1 (Himmelskörper) und Star_2 (Berühmtheit) – in der Annahme, dass der Syllogismus wieder seine Arbeit tun kann, wenn man die Bedeutung der Begriffe klar festlegt. Leider verschiebt sich damit das Problem in einen neuen, noch weniger handhabbaren Bereich, nämlich den der Trennung von Bedeutungen. Ein Beispiel:

All stars shine brightly

Rhianna is a star

Therefore Rhianna shines brightly

Keine noch so gute Begriffs-Disambiguierung kann dieses Beispiel aufklären. Die Schlussfolgerung scheint gültig zu sein, und sie scheint aus den ersten beiden Prämissen zu folgen. Es ist auch klar, dass zwei verschränkte Bedeutungen des Wortes „Star“ verwendet werden. Rhianna leuchtet nicht buchstäblich, daher ergibt sich die Wahrheit des letzten Satzes aus der Verbindung von „Star“ als Metapher für Berühmtheit mit Sternen als brennenden Gaskugeln. Man kann die Begriffe nicht einfach in ihre eigenen Symbole zerlegen, ohne die Wahrheit der Schlussfolgerung zu untergraben.

Dieses Problem tritt auch in Prolog auf, der weltweit populärsten logischen Programmiersprache. Obwohl sie die Logik erster Ordnung modelliert, bietet sie keine Möglichkeit, die Art der Disambiguierung zu bewältigen, die im wirklichen Leben erforderlich ist. Zum Beispiel die Prolog-Regel

Tier(X) :- Katze(X)

wird als „alles, was eine Katze ist, ist auch ein Tier“ gelesen. Das funktioniert nicht, wenn es sich um Spielzeugkatzen handelt oder wenn das Bild einer Katze in manchen Kontexten als Katze interpretiert werden sollte, in anderen Kontexten aber nicht. Die Sprache ist zu starr, um Intentionalität in ihren Regeln zu kodieren.

Gibt es Möglichkeiten, die obigen Unklarheiten zu beseitigen? Wahrscheinlich. Man könnte ein zusätzliches Untersystem für Beziehungen mit Metaphern hinzufügen. Der Punkt ist, dass Ihre KI ihre logischen Formalismen ständig aktualisieren muss, um aufkommende Komplikationen zu berücksichtigen. Dies ist ein nie endender Prozess. Die Geschichte der formalen Logik ist ein Kompendium der Entwicklung neuer Logiken – Fuzzy-Logik, parakonsistente Logik, nicht-monotone Logik -, wenn die Grenzen der alten Logiken entdeckt werden. Das ist etwas, was man nicht tun könnte, wenn der Verstand einfach fest auf einen bestimmten Formalismus programmiert wäre und dieses Paradigma als absolute Notwendigkeit betrachten würde.

Die Notwendigkeit – das Gefühl, zu Schlussfolgerungen getrieben oder gezwungen zu werden – ist das Markenzeichen der „Logik“ in der westlichen Philosophie. – Hegel (Dialektik), Stanford Encyclopedia

In der Realität akzeptiert man selten eine logische Schlussfolgerung als richtig, nur weil man einem soliden logischen „Algorithmus“ gefolgt ist, um dorthin zu gelangen. Häufiger beurteilen Sie die Richtigkeit des Algorithmus rückwirkend danach, ob Sie die Schlussfolgerung für richtig halten, wie Sie es in den obigen Beispielen getan haben. Da Rhianna nicht im Weltraum war, haben Sie sofort einen Fehler in der Logik vermutet; da sie aber „hell leuchtet“, hat Ihre Intuition in die andere Richtung tendiert.

Besondere Erwägungen, die sich aus dem tatsächlichen Inhalt eines Syllogismus ergeben, bestimmen, wie Sie die Logik anwenden und wie Sie diese Tätigkeit später in einen allgemeineren logischen Formalismus abstrahieren können. Wie die Antivirensoftware eines Computers verfeinern und aktualisieren Sie Ihre Methoden, wenn sie nicht mehr ausreichen, um den Anforderungen eines bestimmten Falles gerecht zu werden. Und es wurde noch keine Logik erfunden, die allgemeingültig ist.

Dieser Ansatz der Logik mit selbstgemachten Werkzeugen wird in der KI nur selten aufgegriffen, weil noch niemand untersucht hat, wie eine KI Konzepte wie „Konsistenz“, „Implikation“ oder „Konjunktion“ von Grund auf neu erschaffen könnte, ohne dass sie in irgendeiner Weise bereits in die Architektur eingebaut wären, was sie somit zwingend erforderlich machen würde. Allein schon die Aussicht darauf scheint unmöglich.

Der Rest dieser Serie beschreibt, wie so etwas geschieht.

Lernen, dass 9 gleich 9 ist

Um zu verstehen, wie eine künstliche Intelligenz eine robuste formale Logik⁸ entwickeln könnte, eine, die mit der Situation des grünen Schwans umgehen kann, können wir nach Hinweisen darauf suchen, wie dieselben Techniken allmählich von Menschen erlernt werden.

Und sie werden gelernt. Logische Kohärenz ist weder etwas, wonach Kinder von Natur aus streben, noch ist es eine natürliche Art des Denkens. Es ist eine erworbene Fähigkeit. Zugegeben, die Fähigkeit, dass ein beliebiger Gedanke zu einem anderen, willkürlichen Gedanken führt, ist in der Tat angeboren, aber die Verbindungen zwischen den Gedanken sind standardmäßig nicht logisch und unstrukturiert und beruhen auf wenig mehr als Zufall, Assoziation und persönlicher Vorliebe. Sie sehen dies an den scheinbar irrationalen Äußerungen von Kindern; Sie könnten ihre chaotischen Äußerungen sogar mit Lügen verwechseln.

Betrachten Sie den folgenden Austausch per Videochat zwischen einem Grundschullehrer, den ich kenne, und einem 6-jährigen Schüler:

Lehrerin: Jetzt schreibe zwei Neunen unten auf den Bildschirm.

Schüler: OK. (Er schreibt zwei ‚9‘, wie gefordert)

Herr Lehrer: Was machen wir mit den Neunen, wenn wir sie addieren? Schreiben Sie die Antwort daneben.

Schüler: Ich sehe keine Neun.

Herr Lehrer: Du siehst keine Neunen.

Schüler: Wo sind sie denn?

Herr Lehrer: Was hast du gerade geschrieben?

Schüler: Ich weiß es nicht?

Herr Lehrer: Was siehst du am unteren Rand des Bildschirms?

Schüler: Eine Neun, und noch eine Eins.

Auch wenn dies nach Täuschung oder Spott klingen mag, war der Schüler aufrichtig. Er hatte die Neunen, die er geschrieben hatte, einfach nicht mit den Neunen gleichgesetzt, die addiert werden mussten. Was Sie hier sehen, ist der Standardzustand des menschlichen Geistes. Etwas so Einfaches wie „Zahlen zu verschiedenen Zeiten und in verschiedenen Zusammenhängen sind gleich“ (d. h. 9 = 9) muss gelernt werden.

Wenn Sie Eltern sind, kennen Sie vielleicht diese verwirrende Irrationalität Ihres Kindes. Kein Kind wird mit einer angeborenen oder auch nur rudimentären Vorstellung von „Gültigkeit“, „Gegenteil“, „Konsequenz“ oder „Wahrheit“ geboren9. Ihr Verstand kennt nur „ich mag“ und „ich mag nicht“. Selbst wenn es darum geht, Überzeugungen zu bilden, werden Sie feststellen, dass ihre Gehirne mit einem Übermaß an Wunschdenken gefüllt sind. Es braucht Zeit und das Feedback anderer, bis sie anfangen, positive Gefühle mit „Wahrheit“ oder „gültig“ und negative Gefühle mit „Ungereimtheit“ oder „Lügen“ zu assoziieren.

Damit ihre Äußerungen und Gedanken soliden Mustern folgen, muss ihnen zunächst durch jahrelange Erziehung eine informelle und formale Logik eingetrichtert werden, die dann als gesellschaftlich sanktionierter Leitfaden für das Denken dient10. Und da man ein Kind unterrichten muss, um mit ihm zu kommunizieren, ist die Sprache der Ort, an dem die formale Logik zuerst im Kopf Fuß fasst. Jede logische Ausbildung beginnt damit, dass andere dem, was man laut ausspricht, Grenzen setzen. Bevor man überhaupt lernt, logisch zu denken, wird einem beigebracht, „logisch“ zu sprechen.

Das mag wie eine Umkehrung der Logik erscheinen – logische Aussagen sollen der äußere Ausdruck logischer Gedanken sein. Aber wie Sie im nächsten Beitrag sehen werden, geht es bei der Logik aus der Sicht eines Kindes zunächst nur darum, bestimmte Formulierungen zu korrigieren.

Fortsetzung folgt in Teil 2.

¹ Für die Zwecke dieser Serie ist „formale Logik“ jede Art von formalisiertem logischem System, z. B. Modallogik, Fuzzy-Logik, deontische Logik, sogar parakonsistente Logik. Da die meisten KI-Systeme um Logik erster Ordnung und Wahrscheinlichkeitslogik herum entwickelt werden, werde ich mich in dieser Analyse auf diese konzentrieren. Alles in dieser Reihe gilt jedoch auch für jede regelbasierte Systematisierung von Wissen, z. B. partonomische/meromoische Relationen (z. B. die Hand ist Teil des Körpers, daher enthält der Körper eine Hand), taxonomische Relationen (z. B. ein Mensch ist eine Art von Säugetier, Säugetiere sind Arten von Tieren, daher sind alle Menschen Tiere), Mathematik, Mengenlehre und so weiter.

² Dies setzt eine Ebene der KI voraus, die es derzeit noch nicht gibt, aber in Zukunft vielleicht geben wird. Es ist zumindest ein Forschungsziel für dieses Gebiet.

Obwohl es eine entfernte Ähnlichkeit zwischen diesem Problem und dem Rahmenproblem gibt, befasst sich das Rahmenproblem mit den unausgesprochenen Konsequenzen mehrerer logischer Operationen, während das „Prädikat-Scoping-Problem“ sich mit der semantischen Gültigkeit eines einzelnen Prädikats beschäftigt. Zufälligerweise kann dasselbe Argument, das in dieser Serie dargelegt wurde, auch für das Rahmenproblem angeführt werden; und dieselbe Lösung ist vorgeschrieben. In der Tat sind fast alle Probleme der logischen KI, wie z.B. das Versagen des gesunden Menschenverstands, auf das gleiche Missverständnis zurückzuführen, das in diesem Artikel beschrieben wird.

⁴ Oder im Fall der Fuzzy-Logik, dass die Summe der Wahrscheinlichkeiten von A nicht 1,0 ergibt.

⁵ Die Logik wird im Allgemeinen als „normativ“ bezeichnet, d. h. sie sagt einem, wie man denken sollte. Diese Bezeichnung wird der sozialen Determiniertheit der Logik nicht ganz gerecht. Mit „Logik ist normativ“ meinen wir im Allgemeinen, dass andere Sie anleiten können, Ihr bestes Denken zu entdecken. In dieser Reihe wird vorgeschlagen, dass Ihr bestes Denken, von Symbolen bis hin zu logischen Operationen, nur in einem gemeinsamen sozialen Kontext entsteht und eine Bedeutung hat. Für einen isolierten menschlichen Geist hat es keine Bedeutung.

⁶ Sie mögen dieser Behauptung widersprechen. Sie können sich ein Szenario vorstellen, in dem ein Individuum, das in der Wildnis geboren wurde und keine Gesellschaft hat, trotz seiner Isolation Symbole und Logik verwendet, z. B. um den Überblick über Nahrung oder das Verhalten von Tieren zu behalten. Eine solche Denkübung macht deutlich, wie schwierig es ist, die eigenen privaten Denkweisen von der Gesellschaft, die sie hervorgebracht hat, zu trennen. Jedes Problem, das mit Hilfe der Logik gelöst werden kann, auch bekannt als Logikrätsel, setzt voraus, dass man sich zunächst eine abstrahierte, idealisierte Vorstellung von den beteiligten Personen macht und diese als Symbole darstellt. Bei Logikrätseln, wie z. B. Ritter und Knappen, müssen Sie sich ideale, fiktive Wesen vorstellen, die immer lügen oder immer die Wahrheit sagen. Solche Wesen müssen strengen Regeln gehorchen, selbst wenn es sich dabei um probabilistische Regeln handelt. Das wirkliche Leben ist jedoch subtil, variabel und unsicher, wenn man es mit den konstruierten Szenarien von Logikrätseln vergleicht. Ein Verstand, der alle Begriffe automatisch und ausnahmslos in strikten und formal definierten Beziehungen denkt, hätte es schwer, mit Nuancen umzugehen. Die Verwendung der formalen Logik muss also optional sein. Das bedeutet, dass der so genannte Wilde einen Grund dafür haben muss, dass einige seiner geistigen Objekte strengen Regeln folgen und andere nicht. Welche Entscheidungskriterien würde er verwenden? Die Antwort, auf die sich die KI-Gemeinschaft derzeit geeinigt hat, ist die „Häufigkeit des Auftretens“, d. h. die Wahrscheinlichkeit. Unter dieser Annahme wird von einer KI erwartet, dass sie die Welt auf der Grundlage der Wahrscheinlichkeit von Ereignissen modelliert, die sich aus ihren früheren Erfahrungen ergibt. Aber kommt der Mensch auf diese Weise zu seinen idealisierten logischen Konzepten? Haben Sie jemals einen Ritter oder jemanden getroffen, der immer die Wahrheit sagt? Die statistische Wahrscheinlichkeit ist nur eine weitere optionale Regel, die Sie außer Acht lassen können; sie ist nicht der zugrunde liegende Mechanismus des Denkens selbst. Ein weiterer Beleg dafür ist der historisch weit verbreitete Glaube an unwahrscheinliche Wunder, Geister, Schamanenmagie und Gespenster. Sie und ich überprüfen auch nicht regelmäßig, ob die Summe der sich gegenseitig ausschließenden Wahrscheinlichkeiten 1,0 ist, oder befolgen das Bayes-Theorem, wenn wir unsere Überzeugungen aktualisieren; deshalb musste Bayes das Theorem ja überhaupt erst darlegen. Ein solches perfektes Denken ist eher ein erstrebenswertes Ziel als ein Standardmodus der Erkenntnis. Der einzige verbleibende Grund, idealisierte, formale Konzepte aus fließenden Erfahrungen zu abstrahieren, besteht also darin, sie als Prüfstein für die Kommunikation, für das gemeinsame Verständnis und die gemeinsame Problemlösung zu nutzen. Sie übersetzen Ihre persönlichen Erfahrungen in einen gemeinsamen symbolischen Raum (Zahlen, Worte), damit Sie und ich sie gemeinsam angehen können. Es ist kein Zufall, dass die Logik untrennbar mit der Sprache verbunden ist, die ein soziales Werkzeug ist. Was den wilden Menschen betrifft, so wäre er ohne Sprachgemeinschaft von jeglichem Grund oder jeglicher Methode und damit von jeglicher Möglichkeit des strukturierten Denkens abgeschnitten. Allein und ohne einen gemeinsamen, in der Gesellschaft verwurzelten begrifflichen Rahmen würden seine Handlungen und Gedanken emotional, abergläubisch und frei assoziativ erscheinen, wie die eines verzweifelten Kriminellen, eines Verrückten oder eines Kindes, mit anderen Worten: „wild“. Ein solcher Geisteszustand ist für Sie und mich nahezu unverständlich, weshalb er auch so unglaubwürdig erscheint.

7 Es mag sein, dass die gesamte formale und informelle Logik der menschlichen Spezies völliger Blödsinn ist, und dass wir das nicht sehen können, weil wir dieselbe Logik benutzen, um ihre eigene Gültigkeit zu beurteilen. Wenn man versucht, eine künstliche Intelligenz auf menschlichem Niveau zu schaffen, muss man sich mit dieser unangenehmen Möglichkeit auseinandersetzen – was ist, wenn die Menschen tatsächlich unwissende Idioten sind? Auf jeden Fall ist es nicht ratsam, sich zu sehr darauf zu konzentrieren, ob die Logik die Realität widerspiegelt.

8 In dieser Serie wird das Wort „Logik“ und nicht „Argumentation“ verwendet. Damit soll die formale, geregelte Denkweise, die mit dem Wort „Logik“ bezeichnet wird, von dem natürlichen und fließenden Akt des Überspringens von einer Idee zur anderen unterschieden werden, dem jeder menschliche Geist folgt. Letzteres habe ich „Argumentation“ genannt, obwohl man es auch einfach „Denken“ nennen könnte. Der Unterschied zwischen Logik und logischem Denken besteht darin, dass logisches Denken nicht konsistent, gültig, solide oder sogar gut sein muss – es ist einfach die Reihe von Gedanken, die man hatte, bevor man zu dem Gedanken kam, den man gerade im Kopf hat.

9 Es wäre auch nicht hilfreich zu sagen, dass eine grundlegende logische Schablone von vornherein im Kopf eines jeden Kindes vorhanden ist und dass dem Kind lediglich beigebracht werden muss, wie es sie auf einzelne Fälle anwenden kann. In Anbetracht der zahlreichen Ausnahmesituationen und radikalen Überschreitungen würde eine solche Argumentation einfach die Frage aufwerfen, warum überhaupt jemand glaubt, dass es diese Schablone gibt, und worin der Unterschied zu dem liegt, dass das Kind die Schablone einfach später im Leben erlernt; und für Letzteres gibt es reichlich Beweise.

10 Dieser Prozess ist nie abgeschlossen. Wunschdenken und motivierte Überlegungen beherrschen den größten Teil unseres Erwachsenenlebens. Daher ist logische Konsistenz eher ein erstrebenswertes Ziel, das die Menschen – mit großer Anstrengung – anstreben können, und nicht die natürliche Vorgabe.

(c) Text: Yervant Kulbashian, Einleitung: Dirk Boucsein

Introduction

The guest post that appears here is by Yervant Kulbashian, whom I got to know and appreciate via a sub on reddit.

Yervant works as an engineering manager on an AI platform for the Canadian company „Kindred“, which is part of the „Ocado Group“. Just for information:

„Founded in 2014, Kindred is a robotics and artificial intelligence (AI) company that develops robots to solve real-world problems. The company’s mission is to improve the lives of human workers with the power of AI robots. Kindred’s cutting-edge technology is the foundation for a number of proprietary platforms, including CORE with AutoGrasp™, designed for autonomous operation of robots in dynamic environments. The team of scientists, engineers and business professionals has set a new standard for reinforcement learning of robots. The company is based in San Francisco and Toronto and is part of the UK-based Ocado Group plc.“ (https://www.apollo.io/people/Yervant/Kulbashian/54a916287468693399953e0c).

And exactly this reinforcement learning as „autonomous operation of robots in dynamic environments“ was the trigger for a very productive correspondence correspondence on my previously published essay „The system needs new structures – not only for/against Artificial Intelligence (AI)“ published there. The focus of our interesting exchange, which we later also continued in our „Zoomposium panel„, was mainly on the „subject-object concept“ for „machine consciousness“ and the possibilities of a symbolic representation or implementation of human language on machines and the logical problems that arise here.

In this context, Yervant had already published his articles on language implementation on machines in September 2022, but these take on a whole new perspective and timeliness in the context of ChatGPT and the possibilities for developing „artificial consciousness„. However, the essays also show very clearly that chatbots are currently nothing more than very smart, „talking parrots,“ but are still very far from semantic concepts of language, let alone conscious use.

Yervant has kindly agreed to publish his 3 articles on the topic with me as well, which I am now successively putting online. To make them accessible to my German readership, I have translated them into German. But the original text is provided below. On the topic of „AC/DC“ (meant only as a bonmot 😉 or „Artificial Consciousness/Digital Consciousness“ there are more projects planned, which I would like to point out here prospectively. But now Yervant or better said „the AI shall come up„:

The Green Swan – On the Usefulness of Logic in A.I.

Abstract

All modern logical A.I.s treat symbols and logic¹ as hard-wired processes that automatically construct an A.I.’s beliefs. In humans, by contrast, the ability to use logic is gradually learned throughout life. Moreover, symbols and logic are both artifacts of communication. They emerge, are validated, and are refined through interactions with other people.

Two important consequences of this to A.I. are that

- the use of logic is always optional; it does not happen automatically, and

- the choice of when and how to use formal logic is socially motivated.

All this is to say that in order to adaptively use and successfully contextualize its use of logic, an A.I. must learn logical concepts and axioms from scratch.

To see why, let’s start with an example: the green swan.

The Predicate-Scoping Problem

Many AI texts assume that the information situation is bounded — without even mentioning the assumption explicitly. — Concepts of Logical AI, McCarthy

Imagine you’re tasked with populating an A.I.’s knowledge base. Your goal is to derive new information from existing facts using logical inference. As part of its understanding of the world, you teach the A.I. that

All swans are white

This is a simple logical statement called a predicate. For this example, assume that all the words in the predicate are well-grounded in the A.I.’s experiences. The A.I. can recognize a swan, and the colour white within its flow of sensory inputs².

Given the above, your A.I. can deduce new information:

Greg is a swan

Therefore Greg is white

Any logical A.I. that could understand the words in the first two statements could, in principle, come up with and evaluate the truth of the last one. Its confidence in the conclusion is directly proportional to its belief in the first two assertions.

But what about the original assertion, that all swans are white? Given the way it’s phrased, in what ways is it true?

Imagine I took a swan, and spray-painted it green. I then presented it to the A.I.

“This swan is spray-painted green, which means it isn’t white” I’d say. “It disproves the original predicate”. As the programmer, you might think “no, it doesn’t. When I wrote that all swans are white, I meant that

All swans are naturally white”

The A.I., however, sees a green swan, and since the original predicate didn’t specify that it should be “naturally white” it incorrectly changes its beliefs to “most swans are white”.

In response, you reprogram the A.I. to include the condition that they be naturally white. Next I take a swan and hold it under a purple light. “I have again disproved the statement” I say.

You rephrase it once more: “When I said that all swans are white, I meant that

All swans are naturally white, under common lighting conditions”

The A.I. is not aware of this nuance either. Its automated inference engine is not adaptive enough to account for such tricks. So again it needs to be re-trained.

I try a few more shenanigans, chemically altering a particular swan until it glows blue, using yellow-tinted glasses, describing fantastical swans from literature, etc. In each case, you refine the original assertion to specify what it actually meant. Finally, I deliver a genuine black swan.

“Now it’s been disproved” you admit, and you let the A.I. adjust its beliefs to “most swans are white”.

What happened? You began with what seemed a straightforward statement — “all swans are white” — yet by the end you’d revealed a whole world of assumptions and hidden conditions. The statement wasn’t truly complete without these. And the caveats are more extensive than I have described. Purple light and chemical modification are recent inventions. Imagine how many ways there could be to subvert this statement in the future.

Such incompleteness is a feature of all predicates; for example “all men are mortal” (what about fictional men?), “the capital of France is Paris” (not in my game of Civilization V), and “Mary doesn’t have a beard” (we all have fine, imperceptible hair covering our bodies). The explicit terms of the predicate are only a fraction of the information contained in it. Words are the outward, and by no means complete, expression of a complex of internal assumptions and intentions.

Throughout my interactions with the A.I. above, the meaning of the words “swan”, “are” or “white” didn’t change; they remained stable and well-grounded. The predicate as written was always clear. The issue therefore goes beyond the classic symbol-grounding problem, and indeed assumes that has been resolved. You could call this new problem the “predicate-scoping problem”³.

For an A.I. to effectively apply even basic first order logic to any situation, it must be attuned to such nuances and hidden intentions, and adjust how it interprets predicates as new cases arise. Otherwise its manipulation of symbols will be superficial and naive. It will act like a socially stunted person who takes everything literally.

Given that logical predicates are so fluid and ambiguous in their interpretation what, if anything, is the value to an A.I. of using them?

Logical Predicates Are Usually Worthless

[Symbolic] representation precedes learning as well as reasoning …In a localist representation the relevant concepts have an associated identifier. This is typically a discrete representation.— Neurosymbolic A.I., The 3rd Wave

Formal logic isn’t something an A.I. ‘physically’ applies in its interactions with the world. It can only use logic on a mental model of the world, on ‘ideas’ that it has refined from its experiences. Its network must first pin down a wildly varying influx of sights and sounds into useful patterns that represent an object, concept, event, or probability distribution of events. It creates a model to interpret a series of colours as, say, a “chair”, or a longer series of them as a “war”. As it learns new representations of the world it starts to perceive new concepts, such as “taxes” or “relativity”, and applies logic to those.

Logical reasoning can only be implemented on the basis of clear, accurate, and generalized knowledge — Logical Pre-Training of Language Models

Since formal logic can’t work with vague feelings or intertwined notions, its “objects” must be clearly defined, like numbers, individual’s names, common images, even a vector in latent space. Once an A.I. has defined these terms, the function of formal logic is to maintain a consistent set of mental relationships between them by dictating what new information it can and can’t infer. For instance, when abiding by the rules of first order logic, you aren’t allowed⁴ to assert A and then also assert the opposite of A.

So for formal logic to be able to do its job, its predicates must be concrete symbols. But as you saw above, although predicates are written as simple words, they entail complex networks of contextual assumptions. This means that whenever inconsistencies pop up in the A.I.’s explicit knowledge base, it’s always possible that the terms used don’t actually represent the same thing, e.g.

“Less is more”

Or

“Time is money”

These statements, and in fact most statements in your head (such as metaphors), would be difficult to logically resolve given their explicit terms. So “logically” they should either be changed or made obsolete. But you and I know that many such apparently vague and nonsensical statements do make sense. For an A.I. to be robust it should, like you and I, always have the option to choose whether to resolve an explicit contradiction, or leave it alone. The decision can’t be an automatic hardwired function; it must be motivated by context.

Although modern logical techniques do account with some success for the reasoning involved in verifying mathematical proofs and logic puzzles, they do not explain other cases of technical or common sense reasoning with much detail or plausibility… the utility of the results is controversial. — Logic and AI, Stanford Encyclopedia

All this is to say that an A.I. wouldn’t necessarily understand its environment better, or be more successful if it stringently applied formal logic to what are, after all, mercurial and intertwined statements; no more successful than if it were to hold some number of apparently contradictory beliefs.

Which brings us back to the original question: what exactly is the benefit to you — or to an A.I. — of using formal logic?

“Allowed to”

The answer is hidden in an earlier sentence, where I wrote: you aren’t allowed to assert A and it’s opposite. That is, you aren’t allowed to by other people.

Until now, this post assumed that formal logic would be directly useful to an A.I. alone, regardless of whether there are other agents around, and that logical rules would develop as a consequence of this utility. All current A.I. development presupposes that an agent can benefit from using logic in any context, even in a social vacuum. This is a misunderstanding, and the confusion it has created has negatively impacted the historical development of logic in A.I.

The purpose of this series is to show that formal logic, in humans at least, has its roots in social communication. The so-called rules of logic are a set of constraints you learn to place on your natural, freer (non-logical) modes of thinking. Most importantly, you adopt these rules in response to pressure from other people.

We consider it to be a bad thing to be inconsistent. Similarly, we criticize others for failing to appreciate … logical consequences of their beliefs. In both cases there is a failure to conform one’s attitudes to logical strictures. — The Normative Status of Logic, Stanford Encyclopedia

Your friends — or scientific peers — look for coherence in what you say, as well as in the statements you all agree to as a group; statements like “we’ll all meet in the parking lot”, or “species evolve through natural selection”. So although you may permit your private thoughts to be haphazard and inconsistent, speaking such inconsistencies out loud exposes you to a charge of lying, or at best, not knowing what you’re talking about. And since you often want to convince others — to do something, to believe something, to think a certain way — some amount of self-policing is required for your words to be taken seriously.⁵

In the above exchange over the green swan, for example, the programmer felt compelled to change the words of the predicate to clarify it. She could just as easily have said, “my thoughts on this topic are consistent, and that’s all that matters.” But others can’t read your thoughts, they can only interpret your words. For the sake of cooperation, the world requires you put your free-form thoughts into neat boxes, and draw straight lines connecting those boxes.

The purpose of logic is to characterize the difference between valid and invalid arguments. A logical system for a language is a set of axioms and rules designed to prove exactly the valid arguments **statable in the language.** [emphasis mine] — Modal Logic, Stanford Encyclopedia

To be clear, I’m not saying that society teaches you how to use logic in the same way that it teaches you how to tie a rope — something you could have discovered by yourself. I’m saying that words like “coherence” or “consistency” only have meaning in the context of social interactions⁶ — you are coherent to others, you are consistent in your speech. And although you may later internalize these rules and constrain your thoughts as well, their origin and valid domain is always in interpersonal communication.

A Self-Made Toolkit

I’m not suggesting that logic has no “reality”, or is “all made up”, or “subjective”. Whether or not logic is part of the fabric of reality is beyond the scope of this series. In fact I believe in some way logic is part of reality. But your brain doesn’t traffic in reality directly, it deals only in its perceptions of reality.

Nor is it relevant, when it comes to developing A.I., why it is that others insist that you speak logically, as though their insistence were driven by some pervasive truth about the world⁷. The question I’m addressing is how the human brain — and by extension an A.I. — becomes acquainted with logic, creates or acquires the relevant concepts, then applies them. My goal here is not to prescribe how an A.I. should think, but rather predict what it will think on the topic of logic, and why; whether or not the concepts have any analogue in reality. It is a matter of the epistemology of logic.

Making computers learn presents two problems — epistemological and heuristic. The epistemological problem is to define the space of concepts that the program can learn. The heuristic problem is the actual learning algorithm. The heuristic problem of algorithms for learning has been much studied and the epistemological mostly ignored. — Concepts of Logical AI, McCarthy

Until now the majority — possibly all — of A.I. research in logic has been focused on two goals:

- discovering what the ‘correct’ logic to encode is, and

- how an A.I. can effectively apply that logic in its deliberations.

Almost no attention has been given to how an A.I. can acquire logic in the first place, because the assumption is that it never does. Logic is considered a part of the innate infrastructure of the mind, which is supposed to explain why it feels so natural and obvious. So it gets built into each A.I. as a native faculty. Any subsequent testing the A.I. is subjected to happens within a restricted space, one that can be addressed with these built-in tools.

In the real world, however, logical rules must be constantly adapting and changing alongside the agent’s interaction with the world. And that means they must to a large degree be learned, even invented. For example, consider a hypothetical A.I. that is pre-programmed to naively carry out syllogisms:

All A are B

All B are C

Therefore all A are C

As we saw above, such an A.I. would soon run into obstacles related to the meaning of words, when faced with an equivocation, e.g.:

All stars are in outer space

Rhianna is a star

Therefore Rhianna is in outer space

This highlights one shortcoming of using symbols: a concrete symbol can mean many things. You may suppose that the way to solve this problem is to focus on the meaning of the words rather than the words themselves. So you might try to separate a homonym like “star” into different symbols based on their meaning — star_1 (celestial body) and star_2 (celebrity) — the assumption being that if you could clearly nail down the scope of the terms, the syllogism can once again do its work. Unfortunately, this moves the problem into a new, even less tractable space, that of separating meanings. For example:

All stars shine brightly

Rhianna is a star

Therefore Rhianna shines brightly

No amount of term-disambiguation can clear up this example. The conclusion appears to be valid, and it seems to follow from the first two premises. It’s also clear that two entangled meanings of the word “star” are being used. Rhianna doesn’t literally shine, so the truth of the last sentence comes from the connection of “star”, as a metaphor for celebrity, to stars as burning balls of gas. You can’t easily separate the terms into their own symbols without undermining the truth of the conclusion.

This problem is present in Prolog, the world’s most popular logic programming language. Although it models first order logic, it has no way to tackle the kind of disambiguation that real-life requires. For example, the Prolog rule

animal(X) :- cat(X)

is read as “anything that is a cat is also an animal”. This breaks down in cases of toy cats, or the fact that in some contexts a picture of a cat should be interpreted as a cat, and in other contexts it should not be. The language is too rigid to encode intentionality into its rules.

Are there ways to resolve the ambiguities above? Probably. You might add an additional sub-system for relationships involving metaphors. The point is that your A.I. must continually be updating its logical formalisms to account for emergent complications. This is a never-ending process. The history of formal logic is a compendium of the development of new logics— fuzzy logic, paraconsistent logic, non-monotonic logic — as limitations in the old ones are discovered. This is something you couldn’t do if your mind were simply hard-coded to adhere to one fixed formalism, and treated that paradigm as an absolute necessity.

Necessity — the sense of being driven or forced to conclusions — is the hallmark of “logic” in Western philosophy. — Hegel (Dialectics), Stanford Encyclopedia

In reality you rarely accept a logical conclusion as correct simply because you followed a sound logical ‘algorithm’ to get there. More often you retroactively judge the soundness of the algorithm based on whether you feel the conclusion is correct, as you did in the above examples. Since Rhianna was not in outer space, you immediately intuited an error in the logic; but since she does “shine brightly”, your intuition leaned the other way.

Special considerations that arise from the actual content of a syllogism will drive how you apply logic, and by extension how you might later abstract this activity into a more general logical formalism. Like a computer’s antivirus software, you refine and update your methods as they fall short of what is needed in a given case. And no logic has yet been invented that is universally valid.

This self-made-tools approach to logic is rarely addressed in A.I. because no one has yet explored how an A.I. could create concepts like “consistency”, “implication”, or “conjunction” from scratch without having them in some way already built into the architecture, which would thus make them compulsory. The very prospect itself seems impossible.

The rest of this series describes how such a thing happens.

Learning that 9 equals 9

To understand how an A.I. could develop a robust formal logic⁸, one that can handle the green swan situation, we can look for hints in how these same techniques are gradually learned by humans.

And they are learned. Logical coherence is not something children innately strive for; nor is it a natural mode of thinking. It is an acquired skill. Granted, the ability for any of your thoughts to lead to other, arbitrary thoughts is indeed innate, but the connections between thoughts are by default non-logical and unstructured, based on little more than happenstance, association and personal preference. You see this in children’s seemingly irrational statements; you may even confuse their chaotic output with lying.

Consider the following exchange over video chat between an elementary school teacher I know and a 6 year old student:

Teacher: Now write two ‘nines’ at the bottom of the screen.

Student: OK. (He writes two ‘9’s as asked)

Teacher: So what do we do with nines when we add them? Write the answer next to them.

Student: I don’t see a nine.

Teacher: You don’t see any nines.

Student: Where are they?

Teacher: What did you just write?

Student: I don’t know?

Teacher: What do you see at the bottom of the screen?

Student: A nine, and another one.

Though this may sound like deception or mockery, the student was being sincere. He simply hadn’t equated the nines he wrote with the nines that needed to be added together. What you’re seeing is the default state of the human mind. Something as simple as “numbers at different times and in different contexts are the same” (i.e. 9 = 9) must be learned.

If you’re a parent you may be acquainted with such bewildering irrationality in your little one. No child is born with an innate or even rudimentary notion of “validity”, “opposite”, “consequence”, or “truth”9. Her mind only deals in “I like” and “I dislike”. Even when it comes to forming beliefs, you’ll find their brains filled with an overabundance of wishful thinking. It takes time, and others’ feedback, for them to begin associating positive feelings to “truth” or “valid”, and negative feelings to “inconsistency” or “lies”.

For their statements and thoughts to follow sound patterns, they must first have informal and formal logic drummed in through years of education; at which point they act as a socially-sanctioned guides to thinking10. And since teaching a child requires communicating with her, language is where formal logic first gains a foothold in the mind. All logical training begins when others place restrictions on what you say out loud. Before you ever learn to think logically, you are taught to speak “logically”.

This may seem like a reversal of how logic is supposed to work — logical statements are presumed to be the outward expression of logical thoughts. But as you’ll see in the next post, from a child’s perspective logic is initially only about correcting specific verbalizations.

Continued in part 2.

¹ For the purpose of this series, “formal logic” is any type of formalized logical system, e.g. modal logic, fuzzy logic, deontic logic, even paraconsistent logic. Since most A.I. tends to be designed around first order and probabilistic logic, I’ll focus this analysis on those. However, everything in this series also applies to any rules-based systematization of knowledge; for instance partonomic/meromoic relations (e.g. the hand is part of the body, therefore the body contains a hand), taxonomic relations (e.g. a human is a type of mammal, mammals are types of animals, therefore, all humans are animals), mathematics, set theory, and so on.

² This assumes a level of A.I. that currently doesn’t exist, but may in the future. It is, at least, a research goal for the field.

³ Though there is a distant similarity between this problem and the frame problem, the frame problem addresses the unspoken consequences of multiple logical operations, whereas the “predicate-scoping problem” is concerned with the semantic validity of a single predicate. By coincidence, the same argument outlined in this series can also be made about the frame problem; and the same solution prescribed. In fact, nearly all pervasive problems in logical A.I., such as its failures at common sense reasoning, are rooted in the same misunderstanding described in this article.

⁴ Or in the case of fuzzy logic, that the sum of probabilities of A don’t add up to 1.0.

⁵ Logic is generally referred to as being “normative”, in that it tells you how you ought to think. This designation doesn’t fully appreciate how socially determined it is. Generally, by “logic is normative”, we mean that others may guide you to discover your best thinking. This series proposes that your best thinking, from symbols to logical operations, is created, and only has any meaning, in a shared social context. It has no significance to a human mind in isolation.

⁶ You may object to this assertion. You may imagine a scenario where an individual, born in the wilderness, and without society, uses symbols and logic despite his isolation; say, to keep track of food or animal behaviour. Such a thought exercise highlights how difficult it is to disentangle one’s own private modes of thinking from the society that gave rise to them. Any problem that can be solved using logic, a.k.a. a logic puzzle, requires that you first create an abstracted, idealized conception of the entities involved, and represent those as symbols. For example, knights and knaves logic puzzles require you to imagine ideal, fictional entities, who always lie or always tell the truth. Such entities must obey strict rules, even if those are probabilistic rules. But real life is subtle, variable and uncertain when compared to the contrived scenarios of logic puzzles. A mind that automatically thinks about all concepts, without exception, in terms of strict and formally defined relationships would have a hard time dealing with nuance. So the use of formal logic must be optional. What this means is that the so-called wild-person must have a reason to think of some of his mental objects as following strict rules, and others as not following such rules. What decision criteria would he use? The answer the A.I. community has currently banded around is “frequency of occurrence”, i.e. probability. Under this assumption, an A.I. is expected to model the world based on how likely events are to occur, given its prior experiences. But is this how humans arrive at their idealized logical concepts? Have you ever met a knight, or anyone, who always tells the truth? Statistical likelihood is just another optional rule that you can choose to disregard; it is not the underlying mechanism of reasoning itself. This is further evidenced by the historically pervasive belief in unlikely miracles, ghosts, shaman magic, and spirits. Nor do you or I regularly check that the sum of mutually exclusive probabilities is 1.0, or follow Bayes Theorem when updating our beliefs; that’s why Bayes had to exposit the theorem in the first place. Such perfect thinking is more an aspirational goal than a default mode of cognition. The only remaining reason, then, to abstract idealized, formal concepts out of fluid experiences is to use them as a touchstone for communication, for shared understanding and communal problem-solving. You translate your personal experiences into a common symbolic space (numbers, words) so that you and I can address them together. It’s no coincidence that logic is inseparable from language, which is a social tool. As for the wild-person, having no language community he would be completely cut off from any reason or method for, and therefore any possibility of, structured thinking. Alone, and lacking a shared conceptual framework rooted in society, his actions and thoughts would appear emotional, superstitious, and free-associative, like those of a desperate criminal, or a madman, or a child; in other words, “wild”. Such a mental state is nearly incomprehensible to you or I, which is why it seems so implausible.

⁷ It may be that the human species’ entire body of formal and informal logic is complete bunk; and that we can’t see this since we use that same logic to judge its own validity. When trying to create human-level A.I. you must face such an uncomfortable possibility — what if humans are actually unaware idiots? In any case it is not advisable to put too much focus on whether logic reflects reality.

⁸ This series uses the word “logic”, and not “reasoning”. This is to distinguish the formal, regulated modes of thinking denoted by the word “logic” from the natural and fluid act of jumping from one idea to another that every human mind follows. The latter I’ve called “reasoning”, though you might just call it “thinking”. The difference between logic and reasoning is that reasoning doesn’t need to be consistent, valid, sound or even good — it’s just the set of thoughts you had before you arrived at the one currently in your head.

9 Nor would it be helpful to say that a basic logical template exists apriori in the mind of every child, and that the child merely has to be taught how to apply it to individual cases. Given the number of exceptional situations and radical transgressions, such a line of argument would simply beg the question of why anyone would believe it exists in the first place, and how it would be different from the child simply learning the template later in life; and we have ample evidence of the latter.

10 This process never complete. Wishful thinking and motivated reasoning dominate most of our adult lives. As such, logical consistency is more an aspirational goal humans may strive towards — and with great effort — as opposed to the natural default.

(c) Text: Yervant Kulbashian, Introduction: Dirk Boucsein

https://orcid.org/0009-0008-6932-2717

https://orcid.org/0009-0008-6932-2717

Ein schöner Beitrag, der darauf hinweist, dass Logik ein soziales Konstrukt ist und nicht ein transzendentes Prinzip und sich ebensowenig auf die binäre Algorithmik von Computermodellen beschränken lässt.

Der soziale Determinismus trifft allerdings nicht auf ein Stück Holz oder eine Blume, sondern auf einen biologischen Organismus. Die Frage ist also, wie prozessiert ein biologisches, sich selbst organisierendes System in einem determinierenden System. Der Subjekt-Objekt Beziehung kommt die innere Entwicklungslogik hinzu, ohne die der Mensch bloßes mechanisches Werkstück wäre. Damit ist keine angeborene Grammatik gemeint (Chomsky), sondern eine biologische Logik, wie sie etwa im Entwicklungsmodell Piagets zum Ausdruck kommt.

Menschenähnliche maschinelle Intelligenz muss ungemein viele Aspekte berücksichtigen, die keinesfalls nur auf sprachlicher Ebene liegen.

Es gilt also nach den dem Leben zugrunde liegenden Prinzipien zu suchen und diese zu operationalisieren.

Insoweit bleiben derzeitig als intelligent bezeichnete Computersysteme Lichtjahre von menschlicher Intelligenz entfernt, bei der es gar nicht um Rechenleistung geht, sondern um Anpassung.

Hi Wolfgang,

vielen Dank für Deinen Kommentar und die netten Worte; ich werde sie Yervant weiterleiten.

Ich wollte nur kurz auf Deinen Beitrag eingehen, mal schauen, ob es mir gelingt.

Tja, ich weiß nicht, aber ich glaube, Du engst den von Yervant verwendeten Begriff von „Logik“ ein wenig zu stark ein. Wenn ich Yervant und seinen Text richtig verstanden habe, gehst es ihm nicht so sehr um eine „Ontologie der Logik“, sondern vielmehr in wie weit wir als Menschen in der Lage sind, mit unserer „menschlichen Logik“, wenn sie denn auf unserer „menschlichen Sprache“ basiert, zu eindeutigen, klaren und präzisen Prädikationen kommen kann, die einer Maschine als Orientierung in ihrer Umwelt dienen kann. Das gelingt uns ja noch nicht mal im alltäglichen Leben, wie wir an den hier schon so oft diskutierten Missverständnissen und Fehlinterpretationen erfahren durften.

Ja, da gebe ich Dir und Yervant Recht, „menschliche Logik“, die auf „menschlicher Sprache“ fußt, ist definitiv ein „soziales Konstrukt“ und unterliegt wahrscheinlich auch einem „sozialen Determinismus“, weil wir uns ansonsten noch schwieriger austauschen und verständlich machen könnten. De Saussure hat das ja schon einmal in seiner Zeichentheorie rauf und runter „dekliniert“:

„Bedeutung ist für Saussure nichts der Zeichensynthese logisch Vorausgehendes, sondern wird konkret im sozialen Austausch, in der Zeichensynthese erzeugt. […] Bedeutung ist keine (ontologische) Eigenschaft von Zeichen, sondern ein Effekt ihrer Verwendung durch die Sprachgemeinschaft, insofern die Parole der ausschliessliche Ort der Hervorbringung sprachlichen Sinnes ist.“ (https://de.wikipedia.org/wiki/Ferdinand_de_Saussure)

Wie weit dies auf die Logik im Allgemeinen zutrifft, wenn sie nicht nur sprachlich, sondern auch mathematisch basiert ist, kann ich momentan noch nicht mit Sicherheit sagen. Ich wollte dieses Thema einmal in meinem nächsten geplanten Essay mit dem Arbeitstitel „Metamathematik – die Ontologie der Mathematik“ genauer untersuchen. Auf jeden Fall sind sich auch hier die Mathematiker noch nicht einig, da diese Grundsatzfrage bekanntlich zur Grundlagenkrise geführt hat. Eins ist in Hinsicht auf die Programmierung von „starker KI“ jetzt schon sicher, sprachbasiert, wie bei ChatGPT, wird dies nur ein kluger, sprechender Papagei, wie der „kluge Hans“; mehr nicht ;-).

Inwiefern es hierzu allerdings einer „biologische Logik“ bedarf, kann ich auch nicht erschließen. Die Logik, wenn es denn eine solche geben sollte, wird meines Erachtens wohl nicht utilitaristsich oder instrumentalistisch an eine Disziplin gebunden sein, so weit sind sich die Mathematiker doch schon mal einig und würden hier keinen Alleinvertretungsanspruch geltend machen.

Zu Deinem Einwand zur „menschenähnliche maschinelle Intelligenz“, die „viele Aspekte berücksichtigen [muss], die keinesfalls nur auf sprachlicher Ebene liegen.

Es gilt also nach den dem Leben zugrunde liegenden Prinzipien zu suchen und diese zu operationalisieren.“ muss ich sagen, dass ich dass Du zu „sprachlichen Ebene“, wie oben beschrieben Recht hast.

Ich befürchte allerdings, dass es gar nicht um eine „menschenähnliche maschinelle Intelligenz“ geht, sondern eher um einen autochthonen Weg. „Maschinelle Intelligenz“ haben wir schon erzeugt, die uns auch schon im Schach und Go schlagen kann. Es geht vielmehr um die Frage nach dem „maschinellen Bewusstsein“, bei der man, wie Du richtig schreibst, nach dem „Leben zugrunde liegenden Prinzipien zu suchen und diese zu operationalisieren“ trachtet. Und wie Du auch vollkomen richtig bemerkt hast, geht es nicht um „Rechenleistung, sondern um Anpassung“. Das „Big Data“-Projekt ist obsolet geworden, es geht um „Big Adaption“.

Ich mache jetzt an dieser Stelle aber lieber mal Schluss, bevor der Kommentar zu lang wird.

Liebe Grüße

Dirk

This is Yervant. I’m writing in English, I hope that’s OK.

I agree that the nature of logic is complex and rooted in the connection between entity and agent. As Dirk mentioned, this article makes no assumptions of what it is, but how individual humans learn about it. I start from the fair assumption that humans aren’t naturally logical thinkers, which we know from experience. I can believe A causes B, and B causes C, and still deny A causes C. There’s nothing that forces me to accept it if I don’t want to, except social pressure. So the performance of logic must be voluntary, and that means it’s a motivated action. So I ask the question of where that desire came from, and how the nature of the desire influences our reasoning.

Digging into the principles of life may not be necessary, if a higher level explanation may suffice. Especially if you agree that logic as practised by humans is an acquired skill. As an analogy, if you’re trying to understand how animals are classified, you could dig into biology and the causes of speciation, or you can recognize that humans name things that look similar with similar names. The latter will explain why they have the names that they do. Those names may be wrong (e.g. how panther used to be a species), but that’s not relevant if you don’t care about getting it right.

I’m not convinced that human formal logic is evolutionarily necessary, only that it’s sometimes useful. You rarely use it, and even when you do, it must be supported by your gut instincts to make sure you don’t devolve into sophistry. In fact, my personal experience leads me to believe that people tend to go with what they want to believe first, and then try to find rational arguments to support it. Rarely do people change their beliefs due to logic. All this leads me to think that by making logic a „fundamental“ feature of human thinking we are giving it way too much credit.

Hi Yervant,

I consider human logic to be a product of evolution and natural selection. More precisely, human logic is a product of a continuous interaction between the organism and the environment developed over the time axis of phylogenesis. Therefore, the logic applied by us, namely logic that seems reasonable from the perspective of the human being, is primarily adapted to the natural environment. Human logic fails beyond our natural environment on a mesoscale here on Earth.

Human logic then develops on the time axis of ontogenesis, as, for example, the developmental psychology investigations by Piaget demonstrated. Human logic is, therefore, a product rooted in phylogenetic and ontogenetic developments.

Therefore, I would not build upon human logic concerning epistemological and ontological questions, but I would primarily derive from empirical observations and analyses, even if the former contradict human logic. Our human logical abilities are likely too constrained if empirical observations and analyses contradict human logic. This position is what many philosophers still do not accept. They strive for logical adequacy instead of empirical adequacy. They nest the empirical realm within a logical but deeply anthropocentric point of view.

I consequently agree with you when you claim that we shouldn’t overestimate our human logical abilities. Instead, I would reject all that a priori-based reasoning (based on logic) one so often finds in philosophy.

Philipp

I am curious about this approach. It is, of course, compatible with the contents of the original post. It seems like what you’re interested in is how to correct logical thinking. My post also assumes that every individual must first discover that they even need to engage in logic of some kind, and then tries to figure out how to do that; there is a process involved in this.

How that ends up is determined by their socio-cultural circumstances. When people emphasize strict logical formalizations (logical adequacy), they are often doing so because (1) that’s part of what they’ve been taught, (2) it’s somehow useful to their community of research practice. The AI research community is squarely in the a priori-based reasoning camp, since it is easiest and most convenient to formalize and emulate.

I meant to say that social-cultural factors, i.e., the environment, do not fully determine logical or rational thinking. Instead, human abilities concerning logic, such as our logical categories, are primarily rooted in our evolutionary history.

Lieber Dirk,

ich habe Yervant keine Ontologie der Logik unterstellt, gerade deshalb habe ich ja auf die Notwendigkeit einer Ontologie verwiesen. Logik wird gerne als Weltprinzip verstanden, ähnlich dem Hegelschen Weltgeist. Dass sie eigentlich nur eine Reaktion auf soziale Regeln ist, hat Yervant, wie ich finde, schön dargestellt.

Allerdings ist die Art und Weise dieser Reaktion ja davon abhängig, um welche Art von Subjekt es sich handelt, das da reagiert. Man braucht also, auch im Hinblick auf eine menschenähnliche KI bzw. Bewusstsein ein organismisches Modell, das Auskunft darüber gibt, wie ein solcher Organismus ‚funktioniert‘.

Ich denke über KI nur deshalb nach, weil man sich zwingen muss, in einem Gedankenexperiment die Grundlagen zu benennen und zu begründen, wie und warum menschliche Intelligenz bzw. Bewusstsein funktioniert bzw. was es ist. Und hoffe gleichzeitig, dass man sie nie nachbauen kann.

Für mich gibt es zwei mögliche Antworten:

1. Bewusstsein setzt organismische Strukturen voraus, man kann sie nicht künstlich nachbilden, denn der ‚Kern‘ unseres (zentralnevösen) Lebens ist das, was man früher Seele nannte und von dem man nicht genau weiß, was das sein soll.

2. Wenn wir mehr wissen über die Struktur, die Leben ausmacht, wird es möglich sein, alles das künstlich zu erzeugen, was Leben ausmacht.

Zwischen diesen beiden Antworten schwanke ich hin und her.

Das zeigt wahrscheinlich, wie weit ich davon entfernt bin, derzeitige KI für menschenähnlich intelligent zu halten, geschweige denn, ihnen Bewusstsein zuzubilligen. Für mich sind diese Systeme bessere Suchmaschinen, mehr nicht.

Menschliche Logik zu operationalisieren, ist eine sehr schwere Aufgabe, die von allen möglichen Seiten betrachtet werden kann und muss. Ein Aspekt ist z.B. die Frage, wie koppeln Strukturen oder wie kommt es zu Informationsdichte (in Anlehnung an Tononi) oder wie muss das Verhältnis von rationalen zu nichtrationalen Prozessen gesehen werden oder wie ist das Verhältnis zwischen bewussten und unbewussten Prozessen etc.pp.

Man muss also Prinzipien formulieren und sie dann induktiv erschließen.

Wenn man hier schon kategoriale Fehler macht, also Begriffe beliebig aufeinander abzubilden, die nichts miteinander zu tun haben, wird es bereits zu Beginn chaotisch.

Vielleicht muss man auch Konzepte wiederbeleben, die nicht mehr auf der Tagesordnung stehen, etwa die holographische Organisation des Gehirns, wie sie Karl Pribram beschrieben hat. Vielleicht entdeckt man, wenn man offen genug herangeht, neue Prinzipien.

Ein weites Feld 😊

Den Beitrag von Yervant finde ich jedenfalls einen guten Ansatz.

Lieber Wolfgang,

vielen Dank für Deine sehr interessante Replik, auf die ich hier auch gerne noch einmal genauer eingehen möchte.